Что означает термин платформа ит

Конспект по дисциплине Информационные технологии на тему «Платформа ИТ»

Онлайн-конференция

«Современная профориентация педагогов

и родителей, перспективы рынка труда

и особенности личности подростка»

Свидетельство и скидка на обучение каждому участнику

– это аппаратно-программный комплекс, обеспечивающий базовый набор сервисов, необходимых пользователям для выполнения определенных задач.

Они могут быть универсальными, а могут создаваться для выполнения локальных задач. Выделяют виды платформ:

1) аппаратная – техническое обеспечение вычислительной системы,

2) операционная – обеспечивает интерфейс между прикладными программами и группой операционных систем,

3) платформа управления сетью (административная платформа) – комплекс программ, предназначенных для управления сетью и входящими в нее системами. Такая платформа обеспечивает контроль работы устройств и состояния кабелей, деловых процедур, других аспектов функционирования сети,

4) транспортная – предназначена для передачи данных через коммуникационную сеть,

5) прикладная – связана с прикладными и обслуживающими процессами. Не зависит от типов коммуникационных сетей,

6) коммуникативная – комплекс информационных материалов (методик, практических рекомендаций), обеспечивающий эффективную совместную работу людей в организации.

Курс повышения квалификации

Дистанционное обучение как современный формат преподавания

Курс профессиональной переподготовки

Информатика: теория и методика преподавания в образовательной организации

Курс профессиональной переподготовки

Математика и информатика: теория и методика преподавания в образовательной организации

Ищем педагогов в команду «Инфоурок»

Номер материала: ДБ-1454628

Не нашли то что искали?

Вам будут интересны эти курсы:

Оставьте свой комментарий

Авторизуйтесь, чтобы задавать вопросы.

Учителям предлагают 1,5 миллиона рублей за переезд в Златоуст

Время чтения: 1 минута

В Хабаровском крае введут уроки по вакцинации в некоторых школах и колледжах

Время чтения: 1 минута

В России утвердили новый порядок формирования федерального перечня учебников

Время чтения: 1 минута

МГУ откроет первую в России магистерскую программу по биоэтике

Время чтения: 2 минуты

Рособрнадзор объявил сроки и формат ЕГЭ

Время чтения: 1 минута

ВПР для школьников в 2022 году пройдут весной

Время чтения: 1 минута

Подарочные сертификаты

Ответственность за разрешение любых спорных моментов, касающихся самих материалов и их содержания, берут на себя пользователи, разместившие материал на сайте. Однако администрация сайта готова оказать всяческую поддержку в решении любых вопросов, связанных с работой и содержанием сайта. Если Вы заметили, что на данном сайте незаконно используются материалы, сообщите об этом администрации сайта через форму обратной связи.

Все материалы, размещенные на сайте, созданы авторами сайта либо размещены пользователями сайта и представлены на сайте исключительно для ознакомления. Авторские права на материалы принадлежат их законным авторам. Частичное или полное копирование материалов сайта без письменного разрешения администрации сайта запрещено! Мнение администрации может не совпадать с точкой зрения авторов.

ИТ-экосистемы: как создают платформы из сервисов и для чего это нужно

Боты работают в связке с операторами, увеличивают конверсию и выручку, а менеджеры управляют всеми процессами в режиме «одного окна» — еще пять лет это казалось фантастикой, а сегодня по такой модели работают платформенные омниканальная экосистемы. Игорь Калинин, основатель компании TWIN, разобрался в том, как они устроены и какие задачи решают.

Читайте «Хайтек» в

Боты: проверка на прочность

Технологии синтеза и распознавания речи за последние пять лет стали более демократичными: для создания примитивного голосового бота не нужны навыки программирования, а удобные no-code платформы позволяют с легкостью формировать навыки для голосовых помощников. Появляются даже сервисы, которые могут «клонировать» любой голос, а голосовые дипфейки становятся все более доступными и реалистичными. С одной стороны, индустрия стала демократичной, однако в то же время рынок заполнили «сырые» продукты. Неудивительно, что аналитики Gartner признали чат-ботов (как текстовых, так и голосовых) переоцененной технологией.

Возможности ботов в некоторых сферах действительно переоценивают: например, виртуальному собеседнику сложно вести абстрактные диалоги, шутить и проявлять эмпатию. Но отсутствие развитого EQ и чувства юмора не мешает роботам успешно обрабатывать миллионы звонков в колл-центрах по всему миру. По данным Invesp, за прошлый год 67% потребителей хотя бы раз вели диалог с ботом, а в 2020-м количество диалогов с ботами выросло на 426%. Успешных кейсов тоже становится больше: так, например, бот американской железнодорожной компании Amtrak за год обработал 5 млн запросов в службу поддержки и увеличил выручку на треть.

Но не всем компаниям удается извлечь пользу из роботов. Проблема в том, что бизнес часто запускает виртуального помощника «для галочки» и не интегрирует его с ключевыми сервисами. В результате боты работают недостаточно эффективно, а менеджеры и маркетологи с ними никак не взаимодействуют, занимаясь своими задачами. Решением проблемы становятся платформенные омниканальные экосистемы — новый тренд на стыке ИИ-технологий, менеджмента и маркетинга, который меняет подход к бизнес-коммуникациям.

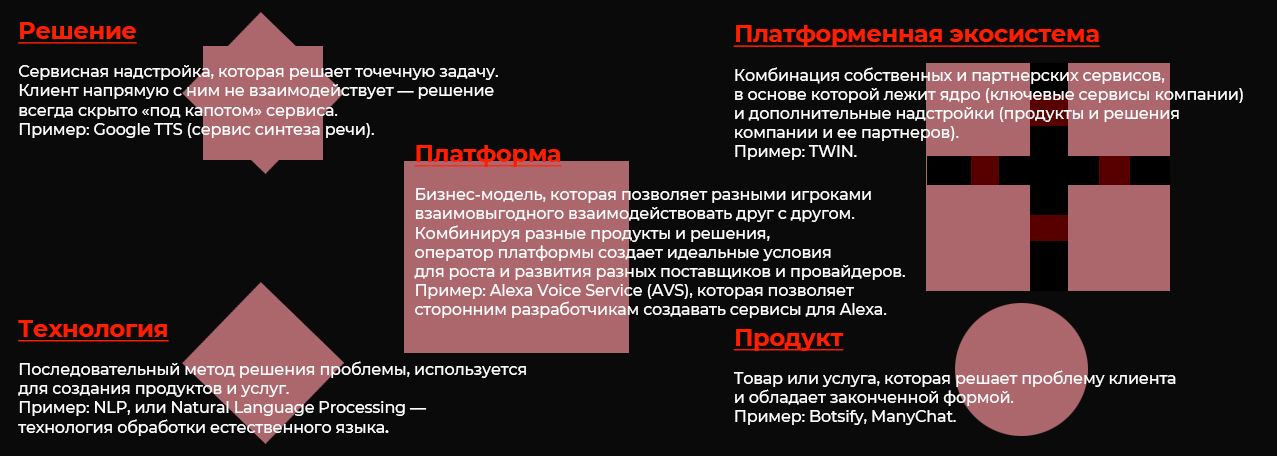

Элементы экосистемы

Если компания разрабатывает голосовых и текстовых помощников под заказ, она предлагает продукт. Клиент решает, как использовать бота, и самостоятельно настраивает интеграцию. По такой модели работают, например, Botsify и ManyChat.

Операторы платформенных экосистем действуют иначе: они создают фундамент, к которому можно подключать различные инструменты. Бот сам по себе — это «винтик» механизма, а экосистема — это уже готовый механизм с тысячей таких «винтиков». Экосистемная модель широко распространена на многих рынках: от финтеха до электронной коммерции, но в сфере виртуального клиентского сервиса она возникла недавно. Отличить ее от обособленного продукта можно по трем ключевым признакам.

Компания со штатом 200–500 человек в среднем использует более 120 SaaS-решений, и выстроить между ними синергию не всегда получается. Подключение виртуальных операторов часто приводит к еще большему хаосу. Стартапы чаще предлагают обособленные точечные решения: например, одни создают виртуального оператора под заказ — пишут скрипты и синтезируют реплики. Другие предлагают только бот-платформы, а третьи — «прикручивают» биллинговые системы. Эти инструменты не всегда удается встроить в CRM-систему и «подружить» с сервисами аналитики. В результате технологии разных провайдеров конфликтуют друг с другом и работают недостаточно эффективно.

Провайдеры платформ обычно предлагают комбинацию услуг под ключ: например, сервис синтеза и распознавания, транскрибации и уведомлений, а также аналитики. Обычно они предоставляют заказчику доступ в личный кабинет с различными модулями — управлять ими может один сотрудник. В нашей практике были случаи, когда такой мониторинг позволял координировать 900 человек одновременно.

Некоторые голосовые платформы работают по закрытой модели и включают в экосистему только собственные разработки, другие встраивают в инфраструктуру сторонние решения — например, в TWIN мы комбинируем собственную технологию TWIN ASR/TTS с системами распознавания и синтеза речи от Яндекса и Google. При этом наша задача как провайдера экосистемы — убедиться, что все стабильно и слаженно работает, а сервисы не конфликтуют друг с другом.

Многие в принципе не любят говорить по телефону и предпочитают мессенджеры: по статистике, 55% потребителей скорее будут пользоваться услугами компании, если связаться с ней можно в мессенджере.

Но как понять, что именно нравится пользователям? Самый эффективный способ — это оценка конверсии и сбор аналитики. Для этого нужно мониторить работу каждого оператора, а это долгий и трудоемкий процесс. Увы, но в России до 80% компаний не собирают статистику по каждому сотруднику и каналу коммуникации, поэтому не знают, что работает, а что нет. Оценить конверсию службы поддержки действительно сложно, поскольку она измеряется не продажами и выручкой, а комплексной комбинацией метрик. А для их сбора требуется смарт-система аналитики, в том числе BI-инструменты.

В TWIN мы собираем и учитываем сотни параметров. Например, звоним клиенту и определяем, каким устройством он пользуется — если это смартфон, то можно прислать короткое SMS со ссылкой на веб-сайт компании, а если кнопочный телефон, то присылаем ему детали в сообщении. Если мы знаем, что клиент пользуется Telegram, то отправляем ему сообщения в мессенджере и в целом прекращаем звонки, а вместо голосового бота используем текстового.

Такой же принцип стоит применять и при рассылке оповещений. Клиент, который пользуется мобильным приложением, получает push-уведомление, а остальным мы отправляем ссылку в Viber, Telegram или WhatsApp — многое зависит от того, какой канал коммуникаций предпочитает сам пользователь и какие данные он нам предоставил. Подобный подход возможен, только если компания подключила инструменты аналитики, а провайдер голосовых технологий получил к ним доступ. Это классические принципы омниканальности, однако теперь на них опираются не только реальные операторы, но и виртуальные сотрудники.

Для технологий на базе машинного обучения такой надежный фундамент — это обязательное требование. Представьте, что было бы, если бы робомобиль внезапно перестал распознавать объекты на дороге, потому что «сервер не отвечает». В случае с ботами главное, чтобы виртуальный ассистент оставался на связи и стабильно мог поддерживать диалог с любым собеседником. Для этого при распознавании наши боты иногда запрашивают вариант ответа у нескольких нейросетей сразу и автоматически выбирают наиболее релевантный. Это тоже положительно сказывается на отказоустойчивости. Использование резервных систем, в том числе сторонних — нормальная практика при разработке решений на базе искусственного интеллекта.

Как платформенные экосистемы помогают бизнесу?

Платформенные экосистемы упрощают коммуникацию с клиентами, оптимизируют процессы и в целом способствуют маркетинговому «прогреву». Компания тратит меньше времени на неэффективные звонки, а главное, быстрее оценивает, какие приемы работают, а какие нет. Виртуальные операторы также сокращают издержки — в среднем, по нашим расчетам, одна минута работы голосового бота стоит 5–7 рублей с учетом всех дополнительных расходов. Услуги оператора обойдутся в 10–15 рублей, если заключить договор со сторонним колл-центром. При создании своего КЦ одна минута работы сотрудника обойдется уже в 35–45 рублей. Многие компании даже не подозревают, во сколько на самом деле обходятся услуги оператора: обычно они делят зарплату работника на количество формально отработанных минут. Но ни один человек не работает нон-стоп без пауз и простоя, а многие затраты просто не учитываются: например, содержание КЦ, бонусные и социальные выплаты.

Из-за этого оценить преимущества ботов могут не все: если бизнес не ведет аналитику и не отслеживает ключевые метрики, голосовая экосистема не принесет ему пользы. Поэтому пока основные клиенты омниканальных платформ — это digital-first компании, которые оцифровали большинство процессов. Банки, транспортные и грузовые службы, онлайн-ритейлеры извлекают из голосовых сервисов наибольшую выгоду. При этом 58% клиентов работает в B2B-сегменте. Большинство использует экосистемы, чтобы сделать коммуникации с ними более эффективными: с помощью виртуальных операторов бренды генерируют лиды, увеличивают конверсию и сокращают издержки на содержание службы поддержки — в среднем на 20%.

Что ждет платформенные экосистемы в будущем?

Постепенно на рынке появляются новые способы применения голосовых сервисов. Например, некоторые используют ботов для работы с новичками и стажерами, а также для налаживания внутренних коммуникаций. Голосовой помощник обзванивает сотрудников, рассылает им приглашения и напоминания о встрече — как реальной, так и виртуальной.

Экосистемы также подключат все больше микросервисов — TWIN предлагает 12 разных надстроек, среди которых система распознавания эмоций и гендерного признака по голосу. Некоторые экспериментируют с определением возрастной категории, а также с биометрией. Новым стандартом становятся надстройки, которые повышают производительность бота. Например, сервисы распознавания автоответчиков — с их помощью боты автоматически выполняют эту функцию и оперативно прекращают диалог.

Еще одна задача разработчиков голосовых систем — это постоянное совершенствование распознавания и синтеза речи. Например, нам удается точно определять до 95% произнесенного текста — это стандарт на рынке и преодолеть его пока сложно. Повысить планку пытаются многие компании, но каждый процент дается с большим трудом. С человеком алгоритмы уже сравнялись — теперь задача выйти за рамки человеческих возможностей, а это непросто.

Платформы анализа данных: что они умеют и как понять, нужны ли они вашему бизнесу

Рынок ИТ- продуктов переполнен предложениями платформенных решений для анализа больших данных: их обсуждают, рекомендуют и внедряют, но всем ли они необходимы? Алексей Ершов, эксперт по продуктам Factory5 (входит в группу Ctrl2GO), ответил на главные вопросы об аналитических платформах для ИТ-директоров, менеджеров проектов и других участников data science инициатив на предприятиях.

Это первая обзорная статья из цикла материалов о платформах анализа данных.

Далеко не все такие инициативы успешны: глобальные исследования Gartner и других компаний показывают, что до 85% проектов не приносят бизнесу результатов. Например, аналитические модели не получается интегрировать в бизнес-процессы. Это происходит по разным причинам, в том числе техническим. Компании работают со множеством сервисов — иногда от разных производителей. Это и инструменты business intelligence, и реляционные и NoSQL-базы данных, и инструменты для big data и data science. Возникают проблемы с интеграцией, передачей данных и их согласованной обработкой. Часть информации может просто потеряться. Эти трудности решает такой класс продуктов, как платформы для анализа больших данных, или, как еще называют, data science платформы.

Платформы анализа больших данных: что это такое и зачем они нужны

Платформа для обработки больших данных — это решение, которое объединяет различные инструменты, необходимые специалистам по data science. Такие платформы существенно упрощают их работу, охватывая весь жизненный цикл data science проектов: от идеи и исследования данных до построения и развертывания аналитических моделей. Они позволяют решить так называемую проблему «последней мили»: интегрировать результаты анализа данных в операционную деятельность, чтобы они влияли на принятие решений и трансформировали бизнес-процессы. Это может быть реализовано в виде API предиктивной модели, к которой обращаются другие системы, веб-приложения, которым могут пользоваться сотрудники, или просто ежедневного отчета, отправляемого на почту.

Объяснить, зачем нужны платформы, можно с помощью простой аналогии. Представьте, что на промышленном предприятии конструкторский отдел разработал новый продукт. Принесет ли один опытный образец пользу бизнесу? Нет — прибыль даст только серийное производство. А для этого потребуется не только оборудование, но и регулярные поставки комплектующих, технологические карты, настроенные процессы контроля качества, обслуживания, модернизации продукта. Чтобы поставить производство на поток, нужны дополнительные ресурсы и компетенции.

Аналогичная ситуация возникает и в data science проектах. Ключевой результат работы дата сайентиста — аналитическая модель — это и есть тот самый опытный образец. Она работает, ее можно запустить, показать в действии. Но если сделать только модель, то на бизнес это не повлияет. Чтобы разрабатывать модели и превращать их из пилотных проектов в работающие бизнес-приложения, чтобы модели работали с потоками данных и не «падали», чтобы выдавали результат за разумное время, нужна соответствующая технологическая оснастка — data science платформы.

Такие решения делают работу data science специалистов прозрачной и масштабируемой. Платформы могут использовать и системные интеграторы, и конечные заказчики, у которых есть специалисты по обработке данных и аналитике.

Какие функции есть у платформ анализа больших данных

Каждый data science-проект проходит жизненный цикл, состоящий из трех этапов:

сбор данных и исследование

экспериментирование и разработка модели

развертывание и интеграция.

На каждом этапе специфические задачи, которые помогает выполнять платформа. И есть более общие задачи, включающие управление данными, управление процессами обработки и масштабирования.

Для решения всех этих задач платформы обработки данных предлагают такой технический функционал: прием, подготовка и исследование данных, генерация признаков, создание, обучение, тестирование и деплой моделей, мониторинг и обслуживание системы. Также платформа должна обеспечивать безопасность данных и их хранение, каталогизацию источников, предоставлять инструменты для визуализации и формирования отчетов. Облачные платформы дополнительно дают большой объем хранилища и вычислительных мощностей.

Все перечисленные функции платформ нужны, чтобы:

Ускорять работу специалистов.

Публиковать модели и интегрировать их в бизнес-процессы.

Делиться понятными, читаемыми результатами анализа с сотрудниками всех подразделений.

Сохранять прошлые наработки, включая метаданные, код, датасеты и обсуждения, и использовать их в новых проектах.

Создать общую базу знаний и собирать лучшие практики, на которых будут учиться новые сотрудники.

Безопасно внедрять новые инструменты, не ломая текущие процессы и не вмешиваясь в работу коллег.

Масштабировать вычислительные мощности.

Контролировать доступы к каждому проекту, чтобы его видели только определенные сотрудники.

Зачем Data Science, если есть системы Business Intelligence

Иногда платформы Data Science воспринимают как аналоги систем Business Intelligence (BI), так как они тоже содержат инструменты для визуализации результатов анализа данных. Важно понимать отличия между ними, чтобы выбирать область применения.

Традиционно BI-решения используются для статических отчетов о текущем или прошлом состоянии бизнеса. Они отвечают на такие вопросы, как: «Какая динамика объема продаж в прошедшем квартале? За счет чего произошел рост или падение продаж? Какой тип продукции произвели больше всего за месяц?». Это так называемый дескриптивный или описательный анализ. Кроме того, BI системы работают со структурированными данными, извлеченными из хранилищ данных и представляют результат анализа в виде интерактивных информационных панелей — дашбордов или отчетов.

Платформы анализа больших данных — это уже инструмент для прогностического и динамического анализа. Они позволяют делать прогнозы по развитию любой сферы бизнеса и на их основе принимать более точные решения. Типовые вопросы: «Какой оптимальный сценарий развития бизнеса? Что будет, если продолжатся текущие тренды? Что случится, если принять новое управленческое решение?». Платформы могут использовать как структурированные, так и неструктурированные данные из множества источников, и умеют обрабатывать большие данные. Так как предиктивный анализ связан нацелен на прогнозирование какого-то параметра или события, то он фокусируется на конкретной задаче, в отличие от business intelligence. Дескриптивный же анализ должен позволять пользователям гибко создавать отчет в том разрезе, который им потребуется.

Современные BI-системы, например, Tableau или PowerBI, имеют большой набор средства визуализации: от линейных графиков и круговых диаграмм до тепловых карт и диаграмм санкей. Поэтому хотя BI-системы и data science платформы предназначены для разных задач, но они могут дополнять друг друга. Например, существующая BI-система может в удобном виде представить результаты анализа данных, которые поступают из платформы.

Платформы или open source

В некоторых компаниях специалисты по big data по-прежнему работают с open source-инструментами. Дата сайентисты чаще всего учатся на них и продолжают использовать их уже на работе. Это подтверждает исследование Normal Research и агенства New.HR при поддержке портала GeekJOB среди аналитиков, в котором респонденты чаще всего упоминают языки Python, R и соответствующие библиотеки (NumPy, Pandas и другие).

Это объяснимо, ведь у таких инструментов низкий технический порог входа: ими легко пользоваться на личном ноутбуке. Но в реальном бизнесе, когда растет и объем данных, и сложность вычислений, когда нужно обеспечить процессинг и масштабирование, объем сопутствующих работ резко увеличивается.

Эти задачи лежат уже в инженерной плоскости, а не в аналитической. Специалисты сталкиваются с необходимостью «подружить» разные решения, поделиться кодом и моделями с другими сотрудниками, а также с вопросами безопасности. На интеграцию уходит дополнительное время, а зачастую это требует и дополнительных расходов. Поддержка разных инструментов тоже закономерно требует больших усилий, чем единого решения. И даже когда open source-инструменты покрывают потребности в обработке и анализе данных, они не интегрированы с другими сервисами компании — в итоге специалистам сложно встроить ML-модели в существующее ИТ-окружение.

Современные платформы анализа больших данных не заменяют, а дополняют известные дата сайентистам open source-инструменты. Они по-прежнему могут разрабатывать модели с помощью привычных фреймворков и библиотек, а платформы предоставляют необходимый технический функционал для продуктивной работы и реализации полного цикла data science проектов. Такой подход позволяет специалистам не переучиваться и быстрее разрабатывать аналитические продукты для бизнеса.

Когда стоит внедрять платформы для анализа больших данных

Обычно в компании у каждой команды есть инструмент для упорядочивания процессов и совместной работы над задачами. Платформы обработки данных — такой же нужный инструмент для дата сайентистов, как система контроля исходного кода для разработчиков, CRM для отдела продаж и helpdesk для технической поддержки. Например, в небольших компаниях вместо CRM используются excel файлы или облачные kanban сервисы. Разные менеджеры могут использовать разные инструменты. На определенном этапе возникают проблемы: информация не хранится в одном месте, нет единого доступа к ней у руководителей, файлы увеличиваются в объеме, в них долго искать информацию и трудно масштабировать такую систему. Схожие трудности возникают и в data science проектах. Вот признаки того, что вам пора начать использовать платформу анализа больших данных:

Снижение продуктивности

Если вы замечаете, что инструментов становится слишком много, вы тратите много времени на рутинные задачи, а время на обработку данных и обслуживание разных инструментов только растет — вероятнее всего, вам пора переходить на DS-платформу.

Трудности масштабирования

Когда вам необходимо тиражировать разработанное приложение на другие направления бизнеса, или один из этапов обработки данных потребовал больше вычислительных ресурсов, то возникает потребность в масштабировании. Если вам нужно масштабироваться, но вы не очень хорошо представляете, как именно это сделать, то платформа просто необходима.

Нехватка прозрачности

Если в команде дата сайентистов начинаются проблемы с коммуникацией, то это говорит об отсутствии централизованных знаний, которыми можно легко делиться между собой. Современные платформы предоставляют доступ разным сотрудникам, вовлеченным в проект.

Рынок data science платформ растет вместе с рынком искусственного интеллекта и углубленной аналитики данных. По оценкам агентства Markets and Markets, рынок платформ для анализа больших данных растет в среднем на 30% в год. Появляются новые продукты, которые разработчики называют «платформами для анализа данных» или “data science platform”, и неподготовленному человеку может быть сложно в них разобраться.