Что значит объем видеокарты

Руководство покупателя игровой видеокарты

Последнее обновление от 28.09.2012

Выбор объёма видеопамяти

Производительность видеокарты определяется не только мощностью самого GPU. Любому чипу нужен большой объём выделенной памяти с высокой пропускной способностью при записи и чтении различных данных: текстур, вершин, содержимого буферов и т. п. Даже самый мощный видеочип можно «придушить» слишком малым объёмом видеопамяти, да ещё с медленным доступом, поэтому характеристики устанавливаемых микросхем памяти также являются одними из важнейших параметров современных видеокарт.

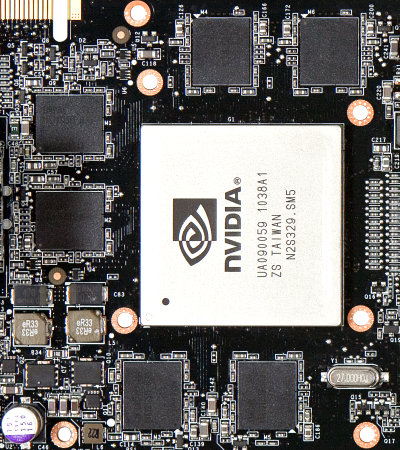

Микросхемы памяти, количество которых на некоторых моделях видеокарт достигает 24 штук, обычно располагаются на печатной плате вокруг видеочипа, на одной или обеих сторонах. В некоторых случаях для них не используется даже пассивное охлаждение, но часто применяется общий кулер, охлаждающий и GPU и память, а иногда и отдельные радиаторы. Вот так микросхемы памяти выглядят на GeForce GTX 590 со снятым устройством охлаждения:

Современные видеокарты оснащаются различным объемом локальной видеопамяти, но обычно он начинается от 512 МБ и может достигать 3 ГБ на один GPU (с удвоением объёма на двухчиповых видеокартах). Чаще всего на видеокарты low-end и mid-end сейчас ставят 1 ГБ памяти, а на high-end — 1,5-3 гигабайта на чип, но есть и исключения. Так, карты самого низкого уровня могут иметь и 512 МБ более быстрой памяти GDDR5, и 1-2 ГБ медленной DDR3.

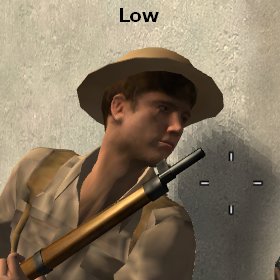

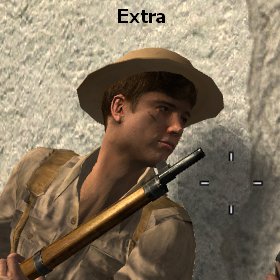

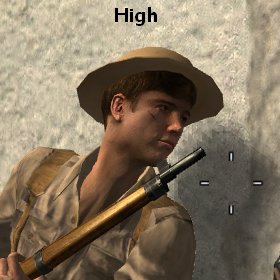

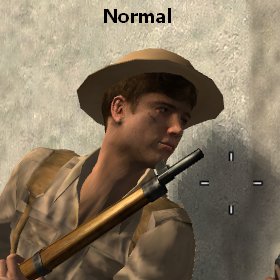

Чем больше выделенной памяти установлено на видеокарте, тем больше данных (тех же текстур, вершин и буферов) можно хранить в ней, не используя медленный доступ к ОЗУ компьютера. Причем, больше всего места занимают текстуры и различные буферы, а вот собственно геометрические данные обычно не слишком объёмны. Рассмотрим скриншоты из довольно старой игры Call of Duty 2 с разными установками качества текстур:

В этой игре, как и во многих других, автоматически настраивается качество текстур под имеющийся объём текстурной памяти. В данном случае режим Extra автоматически выставляется на видеокартах с 320-1024 МБ памяти, High или Normal — на 256 МБ, в зависимости от настроек разрешения и уровня антиалиасинга, а Low — на самых слабых GPU с 128 МБ. И даже если вы выставите максимальные настройки вручную, то на видеокарте с недостаточным объёмом видеопамяти для хранения ресурсов будет использоваться часть системной памяти, что приведет к серьёзным «тормозам» и отсутствию комфорта и плавности в игре.

В последнее время рост требований к объёму видеопамяти сильно замедлился, и виновато в этом засилие мультиплатформенных игр. Современные игровые консоли имеют лишь по 512 МБ памяти и поэтому разработчики игр ориентируются именно на этот уровень. Конечно, в ПК-версиях игр зачастую предусмотрены как текстуры большего разрешения, так и высокое разрешение рендеринга, что требует куда большего объёма видеопамяти. Но всё равно, объём памяти в 1 ГБ до сих пор вполне приемлем в подавляющем большинстве случаев. Кроме экстремальных настроек сглаживания и разрешения, вроде MSAA 8x и 2560×1600, соответственно.

Но даже уже устаревшим мультиплатформенным играм не хватает 512 МБ, они довольно требовательны к объёму видеопамяти, занимая до 600-700 МБ. И всё же, на данный момент минимальным необходимым объёмом локальной памяти для игровых видеокарт мы считаем 1 ГБ. Он же является и оптимальным для большинства моделей. Кроме видеокарт NVIDIA, имеющих 320- и 384-битную шины памяти — у них объём видеопамяти ещё более подходящий — 1280-1536 МБ. Но для топовых моделей уже востребован и больший объём, порядка 2 ГБ, что предлагают видеокарты серии Radeon HD 6900, и 3 ГБ, ставящиеся на некоторые модификации GeForce GTX 580. Тем более, что видеокарту всегда лучше подбирать с небольшим запасом.

К слову, в случае интегрированных видеоядер и устаревших дискретных видеокарт бывает так, что указанное на коробке количество видеопамяти не равно объему установленных на плату микросхем. Такое было ранее в случае видеоплат low-end, работающих с частью системной памяти при помощи технологий TurboCache (NVIDIA) и HyperMemory (ATI):

В характеристиках видеокарт с поддержкой этих технологий в маркетинговых целях указывался объём памяти (в т. ч. и часть ОЗУ), который может использоваться видеочипом, равный 128 МБ, в то время как в реальности на них установлен меньший объем — 16-32 МБ. Поэтому всегда нужно внимательно читать материалы нашего сайта, чтобы не попадаться на подобные ухищрения в будущем. Но пока что можно жить спокойно, ведь сейчас в таких видеокартах уже нет никакого смысла, их нишу прочно заняли интегрированные чипсеты.

С имеющимися разновидностями видеокарт по объёму локальной памяти мы разобрались, но ведь объём памяти для видеокарт — это еще не всё, и даже зачастую не главное! Очень часто бывает так, что на дешёвые видеокарты ставят очень большое количество памяти, чтобы нарисовать красивые цифры на их коробках и в описаниях готовых систем (поэтому их так любят сборщики — вспомните слоганы вроде «4 ядра, 4 гига»), с расчетом на то, чтобы они лучше продавались. Но для слабых видеокарт в повышенном объёме памяти никакого смысла нет, они ведь всё равно не смогут выдавать приемлемую частоту кадров на высоких настройках, в которых и используется большие объёмы текстур и геометрии.

Продавцы часто используют объём видеопамяти в качестве основной характеристики видеокарт, и это вводит в заблуждение простых покупателей, плохо знакомых с реальным положением дел. Сравним производительность решений с разным количеством видеопамяти на примере двух одинаковых видеокарт Radeon HD 6950, имеющих единственное отличие — на первой из них установлено 1 ГБ видеопамяти, а на второй — 2 ГБ. Любой менеджер по продажам скажет вам, что вторая видеокарта значительно лучше первой, кроме случаев, когда в магазине есть модели только с 1 ГБ памяти и редчайших случаев честных и компетентных продавцов. А что получается на самом деле? Есть ли великая разница? Посмотрим на цифры, полученные в игре Metro 2033, являющейся одной из наиболее требовательных:

Как видите, в большинстве игровых режимов объём видеопамяти влияет на производительность не слишком значительно — разница не превышает 5-6%. То же самое получается и в других играх, даже современных и ПК-эксклюзивных (что сейчас большая редкость). Лишь в сверхвысоком разрешении и с максимальными настройками качества появляется значимая разница, когда модель с 1 ГБ заметно отстаёт от более дорогой карты с 2 ГБ памяти — на 27%.

Казалось бы — вот оно, ради чего нужно платить деньги! Но посмотрите на цифры кадров в секунду при разрешении 2560×1600 — разве 18,9 FPS можно назвать комфортной скоростью? Нет. Что 14,9 FPS, что 18,9 FPS — эти цифры одинаково не имеют практического смысла, никто не будет играть с настолько дёрганой частотой смены кадров. Поэтому, с некоторым допущением, можно считать, что разница в объёме видеопамяти между 1 ГБ и 2 ГБ сейчас незначительно сказывается на скорости рендеринга, и сравнивать даже топовые видеокарты по количеству памяти не нужно.

Но речь шла только об объёмах памяти выше 1 ГБ. Да и 512 МБ для плат нижнего ценового диапазона сейчас вполне достаточны. В этих случаях, примеры, когда объём памяти начинает сказываться на производительности, весьма редки. Разработчики игровых приложений рассчитывают используемые в играх ресурсы и графические настройки так, чтобы все данные входили в локальную видеопамять наиболее распространённых на рынке видеокарт. То есть, сейчас это уровни 512 МБ (для low-end) и от 1 ГБ для всех остальных видеокарт, включая и высокие разрешения и максимальные настройки качества. А если видеопамяти меньше, то современные игры или будут тормозить или даже не дадут выставить максимальные настройки.

Но этот расчётный объем видеопамяти у игровых разработчиков растет, даже несмотря на засилие консолей и мультиплатформы. Ещё пару лет назад было вполне достаточно 512-640 МБ, а теперь появились проекты, в которых этот объёма недостаточно. Но даже среди самых последних игр таких проектов пока мало, но они уже появляются. Поэтому, в случае не слишком большой разницы в цене между видеокартами с разными объёмами памяти при прочих равных условиях (частота и ширина шины), следует покупать модель с большим объёмом. Но без погони за цифрами — никакой low-end карте не поможет пара гигабайт медленной DDR3-памяти. Такой объём ей на данный момент просто не нужен. Зато важен другой параметр, о котором мы поговорим далее.

Подробнее о пропускной способности памяти

Ещё одна важная характеристика, о которой мы уже писали — это пропускная способность памяти (ПСП), которая зависит как от частоты работы памяти, так и от ширины шины. Этот параметр определяет количество данных, которые теоретически можно передать в память или из памяти за единицу времени. Другими словами, это скорость, с которой графическое ядро может записывать и считывать различные данные в локальную видеопамять. Соответственно, чем быстрее считываются текстурные, геометрические и прочие данные, и чем быстрее записываются в буфер рассчитанные пиксели, тем выше будет общая производительность.

Пиковая пропускная способность памяти рассчитывается довольно просто — это произведение «эффективной» частоты памяти на количество данных, передаваемых за такт (ширина шины памяти). Например, для GeForce GTX 580 с шиной 384 бит и частотой видеопамяти 1002(4008) МГц, ПСП будет равна:

1002 МГц × 4 (передача данных с учетверённым темпом) × 48 (384/8 байт за такт) ≈ 192,4 ГБ/с

Если с эффективной частотой памяти всё понятно, её обычно везде пишут, и на коробках, и в характеристиках прописывают прямо, то с шиной всё несколько сложнее, ведь она далеко не всегда явно указывается производителем, поэтому на неё нужно обращать особое внимание. Большинство современных видеокарт используют 128-битную или 256-битную шину памяти на один GPU, топовые модели могут иметь до 384 бит, а некоторые недорогие платы оснащаются лишь 64-битной шиной.

Естественно, что последнее нигде широко не афишируется. Для производителя узкая шина и дешевле в производстве, и позволяет удобнее масштабировать производительность решений линейки. И две одинаковые видеокарты с одинаковыми частотами, но с разной шириной шины памяти, будут сильно отличаться по производительности. Та, у которой ПСП больше, может обрабатывать большее количество данных, по сравнению с картой с меньшей разрядностью шины, хотя сами GPU у них совершенно одинаковые.

Рассмотрим очень жизненный пример — модель GeForce GTS 450 с двумя разными типами памяти, GDDR5 на более дорогой модели и DDR3 на дешёвой. Во время выхода на эту видеокарту ставили исключительно быструю GDDR5-память с приличной пропускной способностью. Но когда её время прошло и она спустилась в нижний ценовой диапазон, производители начали экономить, выпуская варианты с DDR3-памятью, которая гораздо дешевле. Результат подобной экономии можно пронаблюдать на следующей диаграмме:

Как видите, всё очень печально для DDR3-варианта — даже в далеко не самой новой игре разница в различных разрешениях экрана составляет от 50 до 70%! То есть, мощность GPU во всех протестированных условиях ограничена медленной видеопамятью. Модель с DDR3 просто не может считывать и записывать данные с теоретически возможной скоростью. Таким образом производители вместе с компанией NVIDIA снизили себестоимость модели, спустив её ещё ниже в бюджетный сегмент.

Поэтому при выборе между видеокартой с бо́льшим и меньшим объёмом видеопамяти нужно всегда смотреть на тактовые частоты, ширину шины и цены! Так, при большой разнице в ценах между двумя решениями среднего и низшего уровней с 1 ГБ и 2 ГБ памяти нет смысла гнаться за дорогим вариантом — видеокарта такого уровня просто не получит большой прибавки в производительности от увеличенного объёма. Но если приходится выбирать между видеокартами с разным объёмом памяти и разной ПСП, то тут выбор уже не так однозначен, и нужно его совершать исходя из того, какого уровня видеокарта и насколько разнятся их частоты. Не забывая и про цену, естественно.

Например, при выборе между топовой видеокартой с 1,5 ГБ памяти и более высокими тактовыми частотами против такой же карты но с 3 ГБ памяти со стандартными частотами и более высокой ценой на данный момент выгоднее будет первая видеокарта, так как она обеспечит даже бо́льшую производительность почти во всех режимах и условиях, кроме самых высоких разрешений. То же касается, к примеру, GeForce GTS 450 с 1 ГБ GDDR5-памяти против GTS 450 с 2 ГБ DDR3 — первый вариант точно будет быстрее. В большинстве режимов видеокарты бо́льшая частота и ширина шины играет значительно более важную роль, чем бо́льший объём видеопамяти, и только в высоких разрешениях увеличенный объем может серьёзно сказаться на скорости рендеринга.

Влияние объема видеопамяти в видеокарте и на что он тратится?

Всем привет! Сегодня рассмотрим, на что влияет объем видеопамяти в видеокарте, вообще и в играх, как именно влияет, сколько нужно видеопамяти для комфортной игры и на какие параметры не влияет.

Дополнительно, если интересно, про видеокарты для 2K монитора можно почитать здесь.

Как используется память видеокарты

Схематически любую современную видеокарты можно представить как графический процессор (GPU), графическую память (GDDR) и связывающую их шину данных.

При запуске игры центральный процессор (CPU) рассчитывает местоположение игровых объектов и их взаимодействие, то есть проводит только арифметические расчеты согласно законам игровой физики.

GPU схематически передаваемые от CPU объекты «заворачивает» в удобный для пользователя формат, то есть рендерит изображение, которое потом выводится на экран. От мощности графического чипа во многом зависит качество графики.

GDDR выполняет роль буфера, где могут временно храниться отрендеренные объекты — например, часть локации игрового мира, а также все здания, персонажи, растения, военная техника и прочие объекты, которые могут там быть.

Чем лучше характеристики видеокарты в компьютере, тем качественнее изображение она выдает в играх. В частности, от объема графической памяти зависит, сколько именно объектов она может запомнить.

Если этот параметр не дотягивает до минимальных системных требований, то с большой вероятностью видеоигра будет вылетать на рабочий стол во время пиковых нагрузок, или же вообще не запустится.

От частоты видеопамяти зависит, как быстро загрузится ранее отрендеренная локация из последнего сейва, если прохождение оказалось неудачным и персонаж погиб. Ширина шины влияет на скорость обмена данными между GPU и GDDR.

Если она слишком низкая, возможны кратковременные фризы и прочие лаги.

Сколько видеопамяти нужно для современных видеоигр

Также нужно учитывать, что объем видеопамяти также влияет на разрешение изображения, которое может «запомнить» видеоадаптер. В 2021 году для комфортной игры на средних настройках достаточно такого объема видеопамяти:

При меньшем, чем необходимо, объеме видеопамяти компьютер будет не дотягивать до системных требований игры, а потому она на установленном разрешении вряд ли запустится.

Единственный выход — запускать ее в окне с разрешением меньше, чем разрешение монитора.

Есть конечно еще и другой вариант — использовать облачный сервис для гейминга, например вот этот или его аналоги(в этом случае от вашего железа крутых технических требований совсем не требуется).

Также советую почитать «Лучшая и самая мощная интегрированная видеокарта 2021 года». Подписывайтесь на меня в социальных сетях, чтобы не пропускать уведомления о новых публикациях. До скорой встречи!

Сколько видеопамяти нужно для компьютерных игр

Видеопамять (или VRAM) — это такое же хранилище данных, как и оперативная память (DRAM) вашего компьютера. Много ли ее надо?

Вы могли заметить, что при настройке графики в играх интерфейс показывает, сколько видеопамяти потребуется при включении той и иной опции. Так вот, для комфортной игры с максимальным качеством отображения нам необходимо выяснить, сколько видеопамяти потребуется. Этим и займемся.

Что важно знать

Что произойдет, если видеопамяти все-таки не хватит?

Страшного — ничего, но впечатление от игры может быть подпорчено, особенно если вы решите поиграть в долгожданную и требовательную новинку. Ждите также проблем с производительностью и текстурами.

Что это значит?

Недостаточная емкость видеопамяти почти всегда означает проблемы с производительностью в играх. При серьезной нехватке VRAM начинает задействоваться более медленная DRAM (оперативная память ПК). В частности, это приводит к более низкой частоте кадров и незначительному притормаживанию.

Проблемы с текстурами — это, например, искажение изображения, задержки и разрывы кадров. Если у вас мало VRAM, вам придется выставлять в настройках игр более низкую детализацию текстур, чтобы при быстром перемещении по игровой карте вы не попадали в ситуацию, когда текстуры на определенном участке не успели полностью прогрузиться. В таких случаях вы вместо, допустим, домов будете видеть белые блоки, а вместо травы — пустое поле.

Сколько VRAM мне нужно для комфортной игры?

В 2021 году для комфортных игр в современные тайтлы нужно минимум 6 Гб видеопамяти. Но лучше всего рассматривать решения с 8 Гб, особенно если вы планируете играть на мониторе с разрешением 2K (1440p) или 4K (2160p). Так что когда вы задаете себе вопрос «Сколько VRAM мне вообще нужно?» — учитывайте следующие факторы:

1. Разрешение, в котором вы запускаете игры

Чем выше разрешение в игре, тем больше видеопамяти вам потребуется. Более высокое разрешение означает дополнительные пиксели, которые увеличивают размер текстуры и требуют больше памяти для ее хранения. Исходя из разрешения, требуемую емкость VRAM можно рассчитать:

Но не только разрешение изображения влияет на емкость памяти.

2. Сами игры, которые вы предпочитаете

Некоторые игры не только поддерживают высокие разрешения в 4K, но и в целом требуют больше видеопамяти. Как правило, это AAA-игры (в духе Call of Duty: Black Ops — Cold War) и игры с плохой оптимизацией (такое часто встречается при выходе новых игр, вспомним, к примеру, PUBG версии 2017 года).

Более качественная графика и количество отображаемых объектов на игровой карте также определяют, сколько памяти она использует. Например, игры с тяжелой графикой, такие как «Ведьмак 3»: Control и Shadow of the Tomb Raider требуют намного больше памяти, чем простые игры, не особо ориентированные на графику, такие как League of Legends и Counter-Strike: Global Offensive.

3. Использование графических модификаций

Иногда использование сторонних модов или графических надстроек может привести к увеличению использования видеопамяти до гораздо больших объемов, чем обычно. Это связано с тем, что некоторые моды добавляют в игры текстуры высокого разрешения (например, в The Elder Scrolls V: Skyrim или Fallout 76). Если использование модов — ваш предпочтительный способ игры, то вам, вероятно, следует рассматривать видеокарты с 6 Гб VRAM и более.

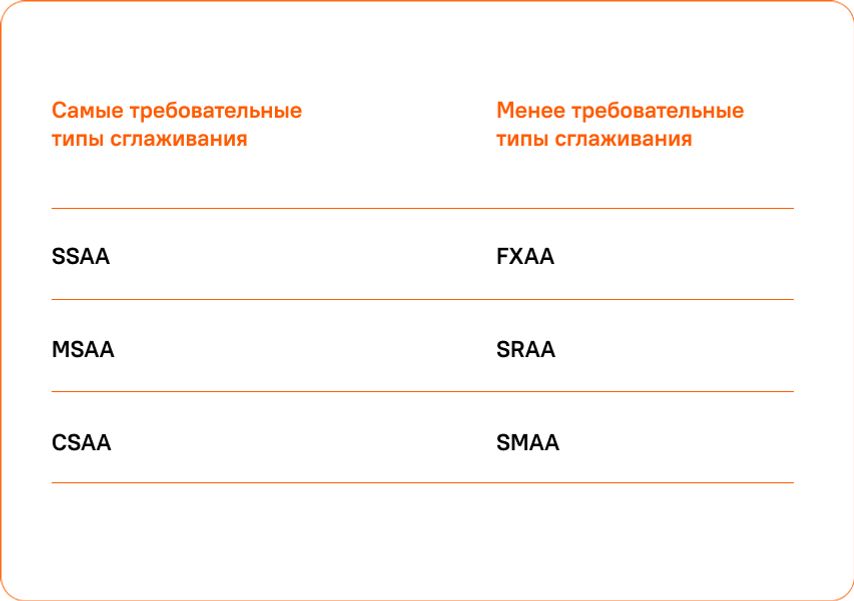

4. Сглаживание очертаний и контуров

Для сглаживания краев объектов и устранения эффекта лесенки в играх используется функция Anti-Aliasing. Чем сильнее сглаживание, тем приятнее получается картинка, однако для этого требуется отрисовать больше пикселей. Поэтому когда этот параметр включен, потребление видеопамяти также увеличивается. Степень его усиления будет зависеть от используемого метода Anti-Aliasing. К наиболее распространенным из них относятся:

5. Настройки параметров игры

Чем выше настройки вашей игры, тем больше данных требуется обработать вашему графическому процессору — и тем больше памяти он потребляет в результате. Поскольку верно и обратное, вы можете понизить настройки игры, чтобы уменьшить использование памяти.

Компромисс или новая видеокарта?

Многим игрокам с видеокартами пятилетней давности, мечтающим о новых играх, приходится снижать настройки графики таким образом, чтобы их игры работали плавно. Помните, что такие настройки, как сглаживание, уровень детализации и качество текстур, больше всего влияют на потребление VRAM (о чем мы и говорили выше).

Если подобные компромиссы вас не устраивают — воспользуйтесь нашим гайдом. В самом начале мы привели приблизительный расчет по части емкости видеопамяти, которая требуется для запуска современных игр с максимальным качеством графики, так что вы без труда определитесь с параметрами VRAM.

Дальше останется лишь выбрать на сайте «Ситилинка» модели видеокарт, удовлетворяющие вашим требованиям, и подобрать оптимальный по цене вариант.

7 распространенных ошибок при выборе видеокарты

Содержание

Содержание

Естественное желание каждого покупателя — получить максимум отдачи от приобретенного товара. То есть — выбрать из конкурирующих решений наиболее качественное, функциональное, либо просто в большей степени соответствующее вкусам нового владельца.

Это стремление логично и не нуждается в каких-либо пояснениях. Но парадокс заключается в том, что чем более технологичным (а следовательно — более дорогостоящим и менее регулярно приобретаемым) является товар — тем в меньшей степени покупатели склонны оценивать его первостепенные характеристики, обращая внимание на менее значимые моменты или вовсе сводя покупку в область эмоций.

Комплектующие для компьютера — в частности, видеокарты, — отнюдь не исключение из этого правила. Ошибок при их выборе совершается немало, и в данной статье мы постараемся осветить основные из них.

Нужно ли смотреть на объем памяти?

К сожалению, фразы вроде «фу, у этой карты 4 гигабайта, на ней только в пасьянс играть!», «у этой видеокарты всего 6 гигабайт памяти, я лучше возьму вот эту — у ней сразу 8!» или бессмертное «у меня карта на 8 гигабайт, эта игрушка на ультра летает!» буквально заполоняют компьютерные форумы, карточки товаров в интернет-магазинах, социальные сети и прочие смежные ресурсы.

Принято считать, что чем больше у карты набортной памяти — тем выше ее производительность, а прочие характеристики либо второстепенны, либо вовсе не имеют значения.

На самом деле, конечно же, это не так.

Набортная память видеокарты сама по себе не влияет на производительность — это всего лишь хранилище для используемых видеокартой данных. И фраза о преимуществах видеокарты с 8 гигабайтами набортной памяти над картой с 6 гигабайтами звучит буквально как «автомобиль с багажником на 500 литров быстрее, экономичнее, комфортнее и лучше в управлении, чем автомобиль с багажником на 350 литров».

Иначе говоря — представляет собой полный абсурд.

Во-первых, производительность видеокарты определяется в первую очередь характеристиками ее ГПУ: количеством исполнительных блоков, архитектурными особенностями, рабочими частотами. Говоря проще — при одинаковом объеме набортной памяти (6 гигабайт), бюджетная GeForce GTX 1660 никогда не будет равна GeForce RTX 2060, стоящей на пару ступеней выше в линейке продуктов.

Но в качестве наглядного примера мы рассмотрим другие карты аналогичных классов:

Встроенный бенчмарк игры Assassin’s Creed: Odyssey запущен в разрешении FullHD с настройками графики, соответствующими штатному профилю «Высокое качество». Конфигурация ПК полностью идентична, за исключением самих видеокарт.

Слева — Radeon RX 5600 XT в исполнении Sapphire с типичными для этой модели 6 гигабайтами набортной памяти.

Справа — Radeon RX 5500 XT в исполнении MSI в версии с 8 гигабайтами набортной памяти.

Частоты видеокарт, в отличие от ЦПУ и оперативной памяти, не приведены к общему знаменателю, но в данном случае этого и не требуется — разница и без того очевидна.

В первом случае по итогу тестовой сцены мы получаем 74 кадра по среднему фпс, 62 кадра по минимальному и просадки до 59 кадров в 1% редких событиий. Во втором — 60, 50 и 48 кадров соответственно.

Так какая карта оказывается быстрее — с 6 или с 8 гигабайтами памяти на борту?

Во-вторых, как уже говорилось выше, память видеокарты — это хранилище данных. А размеры любого хранилища рассчитываются исходя из объема содержимого, которое в него планируется поместить. В случае видеокарты — исходя из объема памяти, который реально задействуют игры. А требования игр — отнюдь не константа, они находятся в прямой зависимости от разрешения экрана и настроек графики. Говоря проще — одна и та же игра на высоких и на средних настройках будет обладать совершенно разными аппетитами.

Рассмотрим следующий пример:

Red Dead Redemption 2, одна из самых требовательных игр последних лет. Здесь используется одна и та же видеокарта — Radeon RX 5500 XT 8gb в исполнении MSI.

Слева используются высокие настройки графики, справа — средние. Разрешение в обоих случаях — FullHD.

Мониторинг позволяет увидеть, что на высоких настройках используется до 6900 мегабайт набортной памяти, так что 8 гигабайт, чтобы поиграть в RDR 2 на высоких, — вполне реальная необходимость. На средних же потребление памяти снижается до 5500 мегабайт — так что карт с 6 гигабайтами памяти на борту для этих настроек тоже хватит. Однако есть одно большое «НО».

C RX 5500 XT, пусть у него и есть необходимые 8 гигабайт памяти, на высоких настройках мы получаем 45 кадров по среднему фпс, 38 — по минимальному и просадки до 36 кадров в 1%.

Бесспорно, многие назовут этот режим играбельным, но, если подходить к вопросу объективно — для по-настоящему комфортного геймплея настройки следует понижать.

На средних же настройках с тем же RX 5500 XT мы получаем 61, 52 и 49 кадров соответственно. Эти показатели как раз и можно назвать комфортными.

Вывод из примеров выше будет следующим:

Объем памяти — важный параметр, но учитывать его необходимо не в отдельности, а только и исключительно в комплексе всех прочих характеристик видеокарты.

Да, в реалиях сегодняшнего дня, даже если вы выбираете видеокарту для игр в самом ходовом разрешении FullHD, следует ориентироваться на карты с объемом памяти в 6 и 8 гигабайт, НО — только в том случае, если выбранная вами карта способна обеспечить комфортный фпс в интересующей вас игре на тех настройках, где эти 6 или 8 гигабайт реально потребуются.

Если же вас интересуют сетевые игры со сравнительно простой графикой, если вы планируете играть в игры не последних лет выпуска, либо если выбирается очень бюджетное решение, способное тянуть тяжелые новинки только на средневысоких настройках — нет смысла гнаться за большим объемом памяти. Во всех этих случаях либо реальное потребление памяти в игре будет сравнительно низким, либо производительность упрется в возможности ГПУ, а не памяти карты.

Так ли важны характеристики разрядности шины памяти или частоты в отдельности?

Этот и последующий пример можно охарактеризовать так же, как и вопрос с объемом памяти видеокарты. А именно — как стремление не рассматривать характеристики продукта не в комплексе, а максимально упростить их, сведя лишь к одному параметру.

Тезисы, разумеется, здесь звучат максимально похоже: «как можно выпускать в 2020 году обрезок со 128-битной шиной?», «да тут всего 192 бита, а еще в прошлом поколении было 256 — я лучше возьму старую карту, она явно быстрее!» и так далее.

Во-первых, помимо ширины шины памяти, есть такие понятия как рабочие частоты и тип памяти. Итоговую пропускную способность подсистемы памяти эти характеристики формируют не по отдельности, а в комплексе. И современные чипы GDDR6 даже на 128-битной шине могут обеспечить те же, или близкие значения к показателям GDDR5 на 256-битной шине.

224 гигабита в секунду против 256 — совсем не та разница, которую следовало бы ожидать, говоря о вдвое «снизившейся» ширине шины памяти.

Однако, во-вторых, сводя все к одному параметру, пусть даже он является комплексным, мы совершаем ровно ту же ошибку, что и рядовые покупатели. Пропускная способность интерфейса описывает лишь максимальный объем данных, который теоретически можно передать за единицу времени.

Ключевое слово здесь — теоретически. На практике же значение имеет архитектура ГПУ и предполагаемые ей алгоритмы сжатия данных.

Рассмотрим очередной практический пример:

Metro: Exodus, встроенный бенчмарк. Разрешение — FullHD, настройки графики — высокие, тесселяция включена, технологии Hairworks и Advanced PhysX — выключены.

Слева — Radeon RX Vega 56, использующий скоростную память типа HBM2 на 2048-битной шине. Справа –GeForce RTX 2060, с типичной для нее GDDR6 на 192-битной шине.

Казалось бы, при таких вводных данных разница в пользу первого решения должна быть очевидной, но на самом деле с Vega56 по итогу теста мы получаем 67 кадров по среднему фпс и 35 — по минимальному, а с RTX 2060 — 66 и 35 кадров соответственно.

Видеокарта — это крайне сложное и технологичное устройство, буквально «компьютер в компьютере», оснащенный собственным процессором, собственным объемом памяти и интерфейсами для передачи данных. И, как у любого компьютера, у видеокарты есть своя архитектура и свой софт, использующий ее преимущества. Поэтому любой параметр, касающийся характеристик видеокарты, нельзя рассматривать в отдельности, а уж тем более — делать какие-то выводы, основываясь исключительно на одном этом параметре.

Впрочем, не совсем так.

Есть один параметр, который действительно может определять и описывать абсолютно все, и согласно которому можно расставлять видеокарты по умозрительной лестнице предпочтений. И это, как легко догадаться — производительность карты в реальных играх.

Корректно ли сопоставлять количество функциональных блоков чипа при сравнении видеокарт разных поколений и от разных производителей?

Характеристики графического процессора, как и центрального процессора компьютера, определяются в первую очередь его частотой и количеством исполнительных блоков — т.е. универсальных шейдерных процессоров, текстурных блоков и блоков растровых операций.

И, как в случае центральных процессоров 6 ядер на частоте в 4000 МГц будут быстрее 4-х ядер на 3400 МГц, так и в случае ГПУ — чем выше частота и больше блоков, тем выше производительность. Однако, тут тоже есть свое большое «НО».

Как и ЦПУ, графические ядра видеокарт можно сравнивать «по цифрам» только в рамках одного поколения и одной архитектуры. Например, Radeon RX 580 с его 2304 процессорами, 144 TMU и 32 блоками ROP будет всегда быстрее RadeonRX 570, характеристики которого можно записать по формуле 2048/128/32.

Но вот когда заходит речь о картах разных поколений или разных производителей — стоит всегда иметь ввиду, что первостепенное значение имеет архитектура, а не частота или количество блоков. Так, карта нового поколения может иметь 2300 универсальных процессоров, а карта предыдущего поколения — все 3600, но в реальных играх полуторакратной разницы вы не увидите:

World of Tanks — правда, уже довольно старой на сегодня версии 1.5.1.3, актуальной на момент проведения тестов. FullHD, настройки графики — ультра.

Слева — Radeon RX 5700, располагающий 2304 универсальными процессорами, 144 текстурными блоками и 64 блоками ROP.

Справа — Radeon RX Vega 56, его прямой предшественник. 3584, 224 и 64 блока соответственно.

Разумеется, частота ГПУ у новинки немного выше, но 240–250 МГц не могли бы обеспечить столь заметный отрыв в производительности при такой разнице в количестве исполнительных блоков. А вот новая архитектура — еще как может!

Оценивать по количественным параметрам и сравнивать между собой можно только видеокарты одного поколения. Если же говорить о картах на принципиально разной архитектуре — можно прийти к условной ситуации, в которой есть некий чип с 1000 универсальных процессоров и его более старый аналог, у которого их 1500.

Казалось бы, второй вариант будет гарантированно быстрее, но вот незадача: 1500 процессоров на старой архитектуре могут выполнять лишь 2 инструкции за каждый такт, а каждый из 1000 новых процессоров — все 4 инструкции.

Пример, разумеется, полностью умозрительный, и аллюзий на реальные графические чипы не предполагающий. Но суть он передает верно.

Как не ошибиться при расчете питания?

Как и любые другие комплектующие, для своей работы видеокарты требуют определенное количество электроэнергии. Соответственно, встает вопрос о том, с помощью чего запитать видеокарту, планируемую к покупке. И в этом случае могут иметь место две крайности:

В обоих этих случаях пользователь оказывается в проигрыше. Поэтому, чтобы не потратить лишних денег и не получить заведомо нестабильную систему, нужно обязательно помнить следующее:

— Блок питания выбирается не «под видеокарту», а под всю систему в целом.

Видеокарта — это только один из составляющих элементов. Помимо нее, в системном блоке также проживают центральный процессор, жесткие диски, оперативная память, материнская плата и, возможно, какие-то платы расширения вроде звуковой карты. Все они в работе также потребляют какое-то количество ватт, и их также нужно учитывать при выборе блока питания.

— Указанная на вашем блоке мощность не обязательно есть в нем фактически.

Качество блоков питания — довольно скользкая тема, и касаться ее в рамках данной статьи мы не будем. Но все же — напомним, что условный блок на 500 ватт, выпущенный в 2010 году и активно эксплуатировавшийся до сегодняшних дней, и современный блок на те же 500 ватт, в реальных замерах выдадут совершено разную мощность. Поэтому, при расчетах совместимости оперировать нужно не цифрами с этикетки, а реальными моделями блоков питания и их фактическим состоянием.

— Фактическое энергопотребление видеокарты и рекомендуемая мощность блока питания — разные вещи.

В характеристиках видеокарт. Указанных на сайтах производителей и в карточках магазинов, можно обнаружить такой параметр, как «рекомендуемая мощность БП». Некоторые часто путают ее с энергопотреблением видеокарты, что и порождает «авторитетные советы» приобретать блоки мощностью 800 ватт к бюджетным видеокартам вроде GTX 1650 — GTX 1660 — RX 5500 XT.

На самом деле, производители видеокарт как раз прекрасно знают предыдущие два тезиса. И рекомендуемая ими мощность — это как раз мощность для ВСЕЙ системы с установленной в нее видеокартой. Более того — мощность эта намеренно завышена, поскольку тем самым производитель защищает себя от претензий со стороны владельцев низкокачественных БП.

Так как определить реальное энергопотребление интересующей вас видеокарты?

Проще всего — прочесть обзор на нее от авторитетного источника. Да, нередко в обзорах указывается энергопотребление всей системы, а не отдельно видеокарты — но так получается даже более наглядно. Ведь, если тестовая система на условном Core i9-9900K в разгоне показывает пиковое энергопотребление на уровне 580 ватт, то ваш компьютер с опять же, условным Core i5-9400F есть будет очевидно меньше.

Впрочем, если в вас вдруг проснется азарт исследователя, можно пойти и более сложным путем.

Одной из основных характеристик современных видеокарт является лимит энергопотребления. Это программное ограничение (аппаратным может являться, разве что, конфигурация разъемов дополнительного питания), по достижении которого видеокарта начинает сбрасывать частоты и понижать напряжения, чтобы остаться в обозначенных пределах.

К примеру, если видеокарта имеет лимит на 130 ватт, то без разгона и ручного поднятия лимита больше есть она не будет — как бы различные «интернет-знатоки» ни советовали вам покупать для нее блоки мощностью 800 ватт минимум.

А поскольку ограничение это программное — узнать его можно напрямую из биос видеокарты. Для этого нужно либо скачать файл и открыть его диагностической утилитой, либо обратиться, например, к базе данных портала Techpowerup.

Слева — отчет утилиты MorePowerTool о лимитах видеокарты Sapphire Radeon RX 5600 XT Pulse. Лимит энергопотребления для ГПУ составляет 160 ватт. Остальные элементы в данном случае не учитываются, однако их потребление существенно ниже чем у ГПУ, для простоты можно округлить до 30–40 ватт.

Справа — информация о видеокарте Gigabyte GeForce RTX 2060 Windforce OC из базы данных Techpowerup. Здесь уже приводится общий лимит энергопотребления, и он составляет 200 ватт.

Разумеется, лимит энергопотребления — это именно пиковое значение, в реальных задачах видеокарта не всегда будет потреблять максимальное количество электроэнергии, но при расчетах мощности БП следует учитывать именно возможный максимум.

И, конечно же, надо помнить, что при разгоне видеокарты лимит энергопотребления вам придется повышать — а, следовательно, нужно закладывать некоторый запас сверх штатного значения. Опять же, здесь поможет изучение характеристик биос карты — так, на примере выше видно, что для конкретно этой версии RTX 2060 штатными средствами лимит можно поднять лишь на 18%.

При расчетах мощности блока питания для вашей системы следует учитывать всего два фактора: реальное энергопотребление ваших комплектующих и не менее реальные характеристики вашего БП. И с первым, и со вторым поможет вдумчивое изучение обзоров.

В крайнем случае — можно просто сравнить энергопотребление видеокарты, которую вы планируете приобрести, с той, которая стоит в вашем системном блоке сейчас. Хотя современные микросхемы и более сложны, их аппетиты вполне могут оказаться ниже, чем у предшественников.

Важно ли подбирать видеокарту под конкретный процессор?

Сегодня вопросы вроде «а подойдет ли эта видеокарта к моему процессору?» по своему количеству и частоте задавания уже уверенно обходят вопросы совместимости с блоками питания. Можно предположить, что здесь действительно есть какие-то тонкости, однако на самом деле это не так.

Если вопрос касается именно совместимости системы с видеокартой — то модель и семейство установленного процессора ее не определяют. Более того: как правило, если видеокарта использует интерфейс PCI-e и поддерживается в установленной на компьютере ОС — это все, что от нее требуется.

Иначе говоря, если вы собираете ПК на новой платформе, но бюджет не позволяет сразу приобрести видеокарту актуального поколения — можно использовать карту, оставшуюся от предыдущей системы, или бюджетное решение старого поколения, купленное на вторичном рынке.

И обратное тоже верно: в компьютеры, собранные на не самых новых платформах, можно устанавливать видеокарты актуальных поколений, если вам не хватает производительности графической части, или бюджет позволяет заменить только видеокарту.

Встроенный бенчмарк игры Assassin’s Creed: Odyssey утверждает, что тестовая система объединяет процессор Intel Corei7-4930K, выпущенный в 2013 году для уже давно устаревшей платформы LGA 2011, и видеокарту GeForce RTX 2080 Ti, выпущенную в конце 2018 года, и актуальную до сих пор.

Причем, разумеется, пример выше — далеко не единственный. При желании в Интернете можно найти множество сборок даже на более старых процессорах — к примеру, Core i5/i7 Sandy Bridge и FX Piledriver, объединенных с современными видеокартами. И не только в виде статичных картинок, но и видеороликов, посвященных сборке и тестированию получившихся систем.

Безусловно, бывают случаи индивидуальной несовместимости, когда видеокарта напрочь отказывается инициализироваться и работать, хотя сама она гарантированно исправна. Но, во-первых, в современных реалиях это большая редкость, а во-вторых, вопросы в данном случае следует адресовать к материнской плате, а не к процессору.

Однако речь может идти не просто о совместимости и возможности эксплуатировать систему с новой видеокартой, но и об итоговой производительности получившегося компьютера в играх. И здесь все уже отнюдь не так просто.

Мифы о «раскрывашках»

«Раскрывашки», наиболее активно нервировавшие интернет-сообщество в период с 2014 по 2018 год, сегодня уже являются в большей степени забавным мемом и поводом для шуток, нежели серьезной проблемой. Однако и сейчас изредка проскакивают вопросы вроде «а раскроИт ли?», в которых потенциальные владельцы новых видеокарт желают знать, насколько быстрой окажется их система после апгрейда.

Согласно популярному заблуждению, к новым и быстрым видеокартам обязательно приобретать процессоры новых поколений. Причем чем выше будет индекс модели — тем лучше для производительности. Хотя реальные системные требования игр, как и соотношение производительности уже имеющегося у пользователя процессора с рекомендуемой ему моделью значения здесь никакого не имеют.

Если же пользователь не желает приобретать новый процессор (разумеется, вместе с полагающейся к нему материнской платой и в некоторых случаях — оперативной памятью), ему заявляется, что и в апгрейде видеокарты нет никакого смысла, ведь работать она будет на уровне младших моделей той же линейки, а то — и вовсе так же, как и старая видеокарта.

Разумеется, все это — крайности, доведенные до абсурда. И ключевая задача любой «раскрывашки» — не помочь, а именно убедить пользователя потратить деньги на новое железо помимо видеокарты. Чего ему, возможно, вовсе и не надо делать.

В реальности, конечно, процессор оказывает существенное влияние на производительность системы. Но, во-первых, не он один, а во-вторых — влияние это не во всех играх одинаково, и уж точно не определяется индексом модели процессора.

Рассмотрим несколько примеров.

Total War: Three Kingdoms. Игра, довольно требовательная к ресурсам центрального процессора и к тому же — использующая преимущества многопотока.

Слева — Intel Core i9-9900KF. Справа — Intel Core i7-9700KF. Оба процессора разогнаны до 5000 МГц, частота кольцевой шины поднята до 4700 МГц, видеокарта RTX 2080 Ti работает в штатном для нее режиме, все прочие условия идентичны.

При этом, в случае с Core i7-9700KF фпс в бенчмарке оказывается… выше!

Да, это исключительно частный случай, связанный с тем, что технология Hyper Threading, отличающая Core i9 от Core i7, в играх далеко не всегда работает корректно, и производительность старшей (. ) модели ЦПУ при прочих одинаковых условиях оказывается ниже, чем у младшей.

Встроенный бенчмарк игры WarThunder, являющейся уже диаметрально противоположным примером. Движок игры по сей день активно использует не более 2-х ядер.

Слева — снова Core i9-9900KF, но на сей раз — в номинальном для него режиме. 4700 МГц по всем ядрам за счет технологии MCE, 4300 МГц на кольцевой шине. Справа — уже Core i5-9600KF, разогнанный ровно до тех же параметров. Все прочие характеристики системы идентичны, в качестве видеокарты опять используется RTX 2080 Ti.

Разница в фпс, опять же, в комментариях не нуждается. В данном случае Core i9 в принципе не может иметь никаких преимуществ над Core i5 — игра попросту не использует «лишние» ядра. А технология Hyper Threading здесь опять ведет себя не лучшим образом, что и позволяет Core i5-9600KF выдавать немного больше кадров в секунду.

И это далеко не единственные примеры, категорически не вписывающиеся в картину мира, предлагаемую раскрывашками.

В реальности у каждой игры свои требования к характеристикам центрального процессора. Так, где-то используется максимально доступное количество ядер — и, например, старые процессоры под ту же платформу LGA 2011 могут не только эффективно справляться с игрой, выпущенной на 7 лет позже них самих, но и обеспечивать более комфортный геймплей, чем современные модели под LGA 1151_v2.

Где-то — наоборот, количество ядер не имеет значения, важна только тактовая частота и производительность в однопоточной нагрузке. Какие-то игры в силу особенностей движка в принципе мало зависимы от процессора и более требовательны к видеокарте. Да и сама «зависимость» от характеристик процессора в одной и той же игре может меняться со сменой разрешения экрана и настроек графики: чем они выше — тем выше влияние видеокарты, и менее заметна разница между более и менее быстрыми ЦПУ.

Раскрывашки же эти факты игнорируют и сводят все к одному простому тезису: «более дорогой и новый процессор — лучше». Но для кого именно лучше — обычно умалчивают.

Заключение

Конечно, в данной статье мы рассмотрели лишь часть распространенных ошибок, совершаемых при выборе видеокарт. Если начинать рассматривать отдельные семейства — да что там, даже отдельные ценовые сегменты! — то легенд и мифов можно будет обнаружить великое множество.

Но и эти, и любые другие мифы рождаются там, где нет четкого знания и подтвержденной информации. Выдумка, изложенная максимально просто и понятно, всегда будет более притягательна, чем факты, которые нужно изучать, анализировать и сопоставлять. Однако опираться на выдумки никогда не стоит.

Если вы хотите получить товар, максимально отбивающий свою цену — стоит сперва потрудиться и изучить сведения о нем сразу в нескольких авторитетных источниках, а не следовать первой попавшейся на глаза рекомендации.