Что означает термин информация

Значение слова «информация»

3. Сведения об окружающем мире и протекающих в нем процессах, воспринимаемые человеком или специальными устройствами. Поток информации.

[От лат. informatio — разъяснение, изложение]

Источник (печатная версия): Словарь русского языка: В 4-х т. / РАН, Ин-т лингвистич. исследований; Под ред. А. П. Евгеньевой. — 4-е изд., стер. — М.: Рус. яз.; Полиграфресурсы, 1999; (электронная версия): Фундаментальная электронная библиотека

Несмотря на широкую распространённость, понятие информации остаётся одним из самых дискуссионных в науке, а термин может иметь различные значения в разных отраслях человеческой деятельности.

Определений информации существует множество, причём академик Н. Н. Моисеев даже полагал, что в силу широты этого понятия нет и не может быть строгого и достаточно универсального определения информации. Тем не менее, в международных и российских стандартах существуют более или менее конкретные формулировки:

знания о предметах, фактах, идеях и т. д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996);

знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015);

сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации (ГОСТ 7.0-99).

Хотя информация должна обрести некоторую форму представления (то есть превратиться в данные), чтобы ей можно было обмениваться, информация есть в первую очередь интерпретация (смысл) такого представления (ISO/IEC/IEEE 24765:2010). Поэтому в строгом смысле информация отличается от данных, хотя в неформальном контексте эти два термина очень часто используют как синонимы.

Первоначально «информация» — сведения, передаваемые людьми устным, письменным или другим способом (с помощью условных сигналов, технических средств и т. д.); с середины XX века термин «информация» превратился в общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире; передачу признаков от клетки к клетке, от организма к организму (например, генетическая информация); одно из основных понятий кибернетики.

ИНФОРМА’ЦИЯ, и, ж. (книжн., офиц.). 1. только ед. Действие по глаг. информировать. И. поставлена на должную высоту. 2. Сообщение, осведомляющее о положении дел или о чьей-н. деятельности, сведения о чем-н. Давать информацию. Газетная и. Неверная и.

Источник: «Толковый словарь русского языка» под редакцией Д. Н. Ушакова (1935-1940); (электронная версия): Фундаментальная электронная библиотека

информа́ция

1. сведения, знания, передаваемые, хранимые или получаемые системой, например человеком; то, что кто-либо сообщает или рассказывает; сообщения, новости ◆ Давать информацию. ◆ Газетная информация. ◆ Неверная информация. ◆ Информация — это различие, которое создаёт различие. Грегори Батесон

2. только ед. то же, что информирование; действие по значению гл. информировать ◆ Информация поставлена на должную высоту.

Фразеологизмы и устойчивые сочетания

Делаем Карту слов лучше вместе

Спасибо! Я обязательно научусь отличать широко распространённые слова от узкоспециальных.

Насколько понятно значение слова спесь (существительное):

Что такое информация?

Исследование How Much Information, проведенное в 2009 году показало, что количество потребляемой в неделю информации с 1986 года выросло в 5 раз. С 250 тысяч слов в неделю до 1,25 миллиона! С тех пор это цифра увеличилась в разы. Далее следуют ошеломительные показатели: в 2018 году количество интернет-пользователей и пользователей социальных сетей — 4.021 млрд и 3.196 млрд. Современный человек за день анализирует невероятное количество информации, применяя различные схемы и стратегии по ее обработке, для принятия выгодных решений. Человеческий вид сгенерировал 90% информации в этом мире за два последних года. Сейчас, если округлять, в день мы производим порядка 2,5 квинтильонов байт (2,5 * 10^18 байт) новой информации. Если разделить это число на количество живущих сейчас людей, то получится, что в среднем один человек за день создает 0,3 гигабайта информации.

Сколько информации занимают Homo sapiens? (далее Homo). Для простоты в информатике придумали термин под названием бит. Бит – это минимальная единица информации. Файл с этой работой занимает несколько килобайт. Такой документ пятьдесят лет назад занял бы всю память самого мощного компьютера. Средняя книга в цифровом варианте занимает в тысячу раз больше места и это уже мегабайт. Качественное фото на мощный фотоаппарат – 20 мегабайт. Один цифровой диск в 40 раз больше. Интересные масштабы начинаются с гигабайтов. ДНК человека, вся информация о нас с вами равна около 1,5 гигабайта. Умножаем это на семь миллиардов и получаем 1,05х10^19 байт. В целом, такой объем информации в современных условиях мы можем произвести за 10 дней. Это количество битов опишет всех живущих сейчас людей. И это только данные о самих людях, без взаимодействий между ними, без взаимодействий с природой и культурой, которую человек сам для себя создал. Насколько увеличится эта цифра, если добавлять переменные и неопределенности будущего? Хаос будет подходящим словом.

Информация обладает удивительным свойством. Даже когда ее нет, она есть. И здесь нужен пример. В поведенческой биологии есть знаменитый эксперимент. Друг напротив друга стоит две клетки. В 1-ой обезьяна высокого ранга. Альфа-самец. Во 2-ой клетке обезьяна статусом ниже, бета-самец. Обе обезьяны могут наблюдать за своим визави. Добавим в эксперимент фактор влияния. Между двумя клетками кладем банан. Бета-самец не посмеет взять банан, если знает, что альфа-самец тоже видел этот банан. Ибо он сразу прочувствует всю агрессию альфа-самца. Далее немного изменяют первоначальные условия опыта. Клетку альфа-самца накрывают непрозрачной тканью, чтобы лишить его обзора. Повторяя все то, что сделали до этого, картина становится совершенно иной. Бета-самец без каких-либо угрызений совести подходит и берет банан.

Все дело в его умении анализировать, он знает о том, что альфа-самец не видел, как положили банан и для него банана просто не существует. Бета-самец проанализировал факт отсутствия сигнала о появлении информации о банане у альфа-самца и воспользовался ситуацией. Постановка конкретного диагноза пациенту во многих случаях производится при нахождении у него определенных симптомов, однако огромное количество заболеваний, вирусов и бактерий может поставить даже опытного врача в тупик, как ему определить точный диагноз, не потратив время, которое может быть жизненно важно для пациента? Все просто. Он производит анализ не только по тем симптомам, которые есть у больного, но и по тем, которых у него нет, что сокращает время поиска в десятки раз. Если что-то не подает тот или иной сигнал, это тоже несет определенную информацию – как правило, негативного характера, но не всегда. Анализируйте не только информационные сигналы, которые есть, но и те, которых нет.

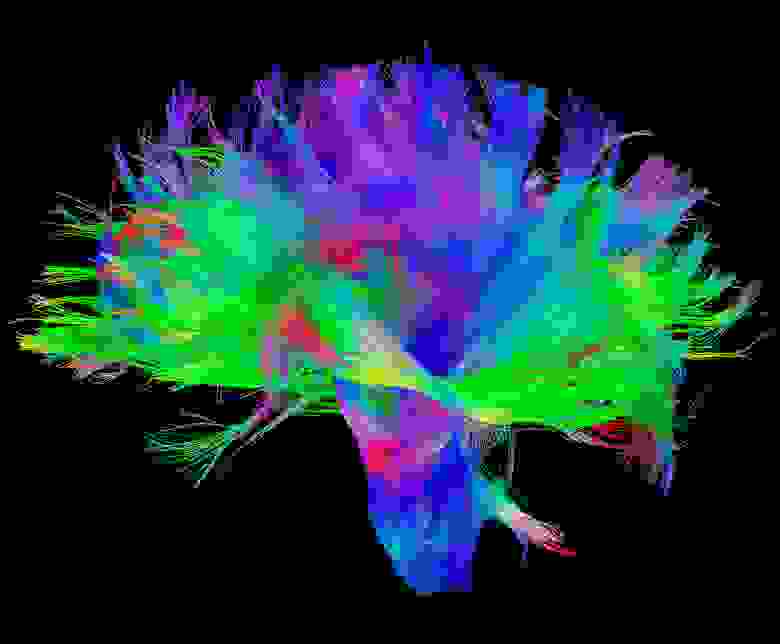

Эти примеры, добавляют нулей и единичек в цифры выше. В связи с перечисленными цифрами и проблемами возникает ряд вопросов. Как? Как этого удалось достигнуть? Способен ли организм/общество нормально функционировать в таких условиях. Как информация влияет на биологические, экономические и другие виды систем. Объем информации, который мы воспринимаем в 2019 году, покажется мизерным для потомков из 2050. Уже сейчас вид создает новые схемы и паттерны работы с информацией, изучает ее свойства и воздействие. Фраза: — “за год я прожил миллион лет” уже не шутки и не абсурд, а реальность. Количество информации, которое создает человек, влияет на социальную, экономическую, культурную и даже биологическую жизнь. В 1980 года мечтали создать квантовый компьютер для увеличения вычислительных мощностей. Мечта вида. Открытия, которое сулило это изобретение, должны были предвосхитить новую эру. В 2018 году IBM запустил в продажу первый коммерческий квантовый компьютер, но этого уже никто не заметил. Новость обсуждали невероятно малое количество людей. Она просто утонула в том информационном изобилии, в котором мы сейчас существуем. Основным направлением исследований в последние годы стали нейронауки, алгоритмы, математические модели, искусственный интеллект, что в целом говорит о поиске возможности нормального функционирования в обогащенной информацией среде. В 1929 году открыли нейроны фон Экономо, которые встречаются только у высокосоциальных групп животных. Есть прямой коррелят размера группы и размера мозга, чем больше группа животных, тем больше у них размер мозга относительно тела. Неудивительно, что нейроны фон Экономо встречаются только у китообразных, слонов и приматов. Нейроны фон Экономо отвечают за передачу больших объемов информации в мозге.

пока А.Г. Лукашенко не запретил им общаться, посмотри на них

Сколько потребовалось времени, чтобы связать эти два события? Долгое время роды вообще не связывали с половыми актами между мужчиной и женщиной. В большинстве культур и религий за рождение новой жизни отвечали боги. Точная дата открытия этой закономерности, к сожалению, так и не установлена. Однако стоит отметить, что до сих пор существуют закрытые общества охотников-собирателей, которые эти процессы не связывают, а за рождение в них отвечают особые ритуалы в исполнении шамана. Основной причиной детской смертности при родах до 1920 были грязные руки. Чистые руки и живой ребенок тоже пример неочевидной закономерности. Вот еще один пример закономерности, которая до 1930 года оставалась неявной. О чем речь? О группах крови. В 1930 году Ландштейнер получил за это открытие Нобелевскую премию. До этого момента знание о том, что переливать человеку можно ту группу крови, которая совпадает у донора с нуждающимся — было неясным. Подобных примеров тысячи. Стоит отметить, что поиск закономерностей то, чем вид занимается постоянно. Бизнесмен, который находит закономерность в поведении или потребности людей, а после зарабатывает на этой закономерности долгие годы. Серьезные научные исследования, которые позволяют прогнозировать изменение климата, миграцию людей, нахождение мест для добычи полезных ископаемых, цикличность комет, развитие эмбриона, эволюция вирусов и как верхушка, поведение нейронов в мозге. Конечно, можно все объяснить устройством вселенной, в которой мы живем, и вторым законом термодинамики о том, что энтропия постоянно возрастает, но этот уровень для практических целей не подходит. Следует выбрать более приближенный к жизни. Уровень биологии и информатики.

Что такое информация? Согласно распространённым представлениям, информация – это сведения независимо от формы их представления или решение проблемы неопределённости. В физике информация – это мера упорядоченности системы. В теории информации, определение этого термина следующее: информация – это данные, биты, факты или понятия, набор значений. Все эти понятия размыты и неточны, более того, я считаю, что немного ошибочны.

В доказательство этого выдвинем тезис — информация сама по себе бессмысленна. Что такое число “3”? Или что такое буква “А”? Символ без приписанного значения. Но что такое число “3” в графе группы крови? Это значение, которое спасет жизнь. Оно уже влияет на стратегию поведения. Пример, доведенный до абсурда, но не теряющий своей значимости. Дуглас Адамс написал “Путеводитель для путешествующих автостопом по галактике”. В этой книге, созданный квантовый компьютер должен был ответить на главный вопрос жизни и Вселенной. В чем смысл жизни и Вселенной? Ответ был получен спустя семь с половиной миллионов лет непрерывных вычислений. Компьютер заключил, многократно проверив значение на правильность, что ответ был “42”. Приведённые примеры дают понять, что информация без внешней среды, в которой она находится (контекста), ничего не значит. Число “2” может означать количество денежных единиц, больных эболой, счастливых детей или быть показателем эрудированности человека в каком-то вопросе. Для дальнейшего доказательства перейдем в мир биологии: листья растений часто имеют форму полукруга и сперва как бы поднимаются вверх, расширяясь, но после определенной точки преломления, тянутся вниз, сужаясь. В ДНК, как в главном носители информации или значений, нет гена, который кодировал бы их такую тягу вниз, после определенной точки. То, что лист растения тянется вниз, проделки гравитации.

Сама по себе ДНК, что у растений, что у млекопитающих, что уже у упомянутого Homo Sapiens, несет мало информации, если вообще это делает. ДНК — это набор значений в определенной среде. ДНК, в основном, несет факторы транскрипции, то что должно быть активировано определенной внешней средой. Помести ДНК растения/человека в среду с другой атмосферой или гравитацией, и на выходе получится другой продукт. Поэтому передавать инопланетным формам жизни нашу ДНК для исследовательских целей — довольно глупое занятие. Вполне возможно, в их среде, ДНК человека вырастет в нечто, что более ужасающе, чем двуногий прямоходящий примат с оттопыренным большим пальцем и идеями о равенстве. Информация — это значения/данные/биты/материя в любой форме и в непрерывной связи с окружающей средой, системой или контекстом. Информация не существует без факторов внешней среды, системы или контекста. Только в неразрывной связке с этими условиями, информация способна передавать смыслы. Говоря языком математики или биологии, информация не существует без внешней среды или систем, на переменные которых она оказывает влияние. Информация всегда является придатком тех обстоятельств, в которых она перемещается. В этой статье будут рассмотрены основные идеи теории информации. Труды интеллектуальной деятельности Клода Шеннона, Ричарда Фейнмана.

Отличительной особенностью вида является способность создавать абстракции и выстраивать закономерности. Представлять одни явления через другие. Мы кодируем. Фотоны на сетчатке глаза создают картинки, колебания воздуха преобразовываются в звуки. Определенный звук мы связываем с определенной картинкой. Химический элемент в воздухе, своими рецепторами в носу, мы интерпретируем, как запах. Через рисунки, картинки, иероглифы и звуки мы можем связывать события и передавать информацию.

вот он собственно говоря и кодирует твою реальность

Подобное кодирование и абстракции не стоит недооценивать, достаточно только вспомнить, насколько сильно оно влияет на людей. Кодировки способны одержать верх над биологическими программами, человек ради идеи (картинки в голове, которая определяет стратегию поведения) отказывается от передачи копий своих генов дальше. Или вспомнить всю мощь физических формул, позволивших отправить представителя вида в космос. Химические уравнения, которые помогают лечить людей и так далее. Более того, мы можем кодировать то, что уже закодировано. Простейшим примером может послужить перевод с одного языка на другой. Один код представляется в форме другого. Простота трансформации, как главный фактор успешности этого процесса, позволяет делать его бесконечным. Можно перевести выражение с японского на русский, с русского на испанский, с испанского на двоичную систему, с нее в азбуку Морзе, после представить это в виде шрифта Брайля, потом в форме компьютерного кода, а после в виде электрических импульсов пустить это прямо в мозг, где он декодирует сообщение. Недавно сделали обратный процесс и декодировали активность мозга в речь.

зафигачили в картинку выше электроды и считали всю твою уникальность

В период от сорока до двадцати тысяч лет назад первобытные люди начали активно кодировать информацию в виде речевых или жестовых кодов, наскальных живописей. Современные люди, наблюдая первые наскальные рисунки, пытаются определить (декодировать) их смысл, поиск смыслов — это еще одна отличительная черта вида. Воссоздавая контекст по определённым маркерам или остаткам информации, современные антропологи пытаются понять быт первобытных людей. Квинтэссенция процесса кодирования воплотилась в виде письменности. Письменность, разрешила проблему потери информации при ее передаче не только в пространстве, но и во времени. Иероглифы цифр позволяют кодировать вычисления, слова предметы и т.д. Однако, если с точностью проблема решена более-менее эффективно, если конечно же оба участника процесса коммуникации используют одинаковые условные соглашения на трактовку и процесс декодирования одних и тех же символов (иероглифов), то со временем и скоростью передачи печатная письменность потерпела неудачу. Для решения проблемы скорости были изобретены системы радио и телекоммуникаций. Ключевым этапом развития передачи информации можно считать две идеи. Первая — цифровые каналы связи, а вторая — развитие математического аппарата. Цифровые каналы связи решили проблему в скорости передачи информации, а математический аппарат в его точности.

Любой канал имеет определенный уровень шумов и помех, благодаря которым информация приходит с помехами (набор значений и иероглифов искажен, теряется контекст) или вообще не приходит. По мере развития технологий, количество шумов в цифровых каналах связи уменьшалось, но никогда не сводилось к нулю. По мере увеличения расстояния вообще увеличивалось. Ключевая проблема, которую необходимо решить при потере информации в цифровых каналах связи, была обозначена и решена Клодом Шенноном в 1948 году, а также он придумал термин бит. Звучит она следующим образом: — “Пусть источник сообщений имеет энтропию (Н) на одну секунду, а (С) — пропускная способность канала. Если H

Информация

Информация (от лат. informatio, разъяснение, изложение, осведомленность) — сведения о чем-либо, независимо от формы их представления.

В настоящее время не существует единого определения информации как научного термина. С точки зрения различных областей знания, данное понятие описывается своим специфическим набором признаков.

Содержание

История понятия

Классификация информации

Информацию можно разделить на виды по различным критериям:

по способу восприятия:

по форме представления:

Значение термина в различных областях знания

Философия

Традиционализм субъективного постоянно доминировал в ранних определениях информации, как категории, понятия, свойства материального мира. Информация существует вне нашего сознания, и может иметь отражение в нашем восприятии только как результат взаимодействия: отражения, чтения, получения в виде сигнала, стимула. Информация нематериальна, как и все свойства материи. Информация стоит в ряду: материя, пространство, время, системность, функция, и др. что есть основополагающие понятия формализованного отражения объективной реальности в её распространении и изменчивости, разнообразии и проявленности. Информация — свойство материи и отражает её свойства (состояние или способность взаимодействия) и количество (мера) путём взаимодействия.

С материальной точки зрения информация — это порядок следования объектов материального мира. Например, порядок следования букв на листе бумаги по определенным правилам является письменной информацией. Порядок следования разноцветных точек на листе бумаги по определенным правилам является графической информацией. Порядок следования музыкальных нот является музыкальной информацией. Порядок следования генов в ДНК является наследственной информацией. Порядок следования битов в ЭВМ является компьютерной информацией и т. д. и т. п. Для осуществления информационного обмена требуется наличие необходимых и достаточных условий.

Достаточное условие одно:

Наличие субъекта, способного распознавать информацию. Это человек и человеческое общество, общества животных, роботов и т. д.

Различные объекты (буквы, символы, картинки, звуки, слова, предложения, ноты и тп.) взятые по одному разу образуют базис информации. Информационное сообщение строится путем выбора из базиса копий объектов и расположение этих объектов в пространстве в определенном порядке. Длина информационного сообщения определяется как количество копий объектов базиса и всегда выражается целым числом. Необходимо различать длину информационного сообщения, которое всегда измеряется целым числом, и количество знаний, содержащегося в информационном сообщении, которое измеряется в неизвестной единице измерения.

С математической точки зрения информация — это последовательность целых чисел, которые записаны в вектор. Числа — это номер объекта в базисе информации. Вектор называется инвариантом информации, так как он не зависит от физической природы объектов базиса. Одно и то же информационное сообщение может быть выражено буквами, словами, предложениями, файлами, картинками, нотами, песнями, видеоклипами, любой комбинацией всех ранее названных. Чем бы мы не выражали информацию — изменяется только базис, а не инвариант.

В информатике

Системология

Работа с информацией связана с преобразованиями и всегда подтверждает её материальную природу:

Системология рассматривает информацию через связь с другими основаниями: I=S/F[MṿRṿT], где: I — информация; S — системность мироздания; F — функциональная связь; M — материя; ṿ — (v подчёркнутое) знак великого объединения (системности, единства оснований); R — пространство; T — Время.

В физике

Объекты материального мира находятся в состоянии непрерывного изменения, которое характеризуется обменом энергией объекта с окружающей средой. Изменение состояния одного объекта, всегда приводит к изменению состояния, некоторого другого объекта окружающей среды. Это явление, вне зависимости от того, как, какие именно состояния и каких именно объектов изменились, может рассматриваться, как передача сигнала от одного объекта, другому. Изменение состояния объекта при передаче ему сигнала, называется регистрацией сигнала.

Сигнал или последовательность сигналов образуют сообщение, которое может быть воспринято получателем в том или ином виде, а также в том или ином объёме. Информация в физике есть термин, качественно обобщающий понятия «сигнал» и «сообщение». Если сигналы и сообщения можно исчислять количественно, то можно сказать, что сигналы и сообщения являются единицами измерения объёма информации.

В математике

В математике теория информации (математическая теория связи) — раздел прикладной математики, определяющий понятие информации, её свойства и устанавливающий предельные соотношения для систем передачи данных. Основные разделы теории информации — кодирование источника (сжимающее кодирование) и канальное (помехоустойчивое) кодирование. Математика является больше чем научной дисциплиной. Она создает единый язык всей Науки.

Предметом исследований математики являются абстрактные объекты: число, функция, вектор, множество, и другие. При этом большинство из них вводится акcиоматически (аксиома), то есть без всякой связи с другими понятиями и без какого-либо определения.

Информация не входит в число предметов исследования математики. Тем не менее, слово «информация» употребляется в математических терминах — собственная информация и взаимная информация, относящихся к абстрактной (математической) части теории информации. Однако, в математической теории понятие «информация» связано с исключительно абстрактными объектами — случайными величинами, в то время как в современной теории информации это понятие рассматривается значительно шире — как свойство материальных объектов.

Связь между этими двумя одинаковыми терминами несомненна. Именно математический аппарат случайных чисел использовал автор теории информации Клод Шеннон. Сам он подразумевает под термином «информация» нечто фундаментальное (нередуцируемое). В теории Шеннона интуитивно полагается, что информация имеет содержание. Информация уменьшает общую неопределённость и информационную энтропию. Количество информации доступно измерению. Однако он предостерегает исследователей от механического переноса понятий из его теории в другие области науки.

«Поиск путей применения теории информации в других областях науки не сводится к тривиальному переносу терминов из одной области науки в другую. Этот поиск осуществляется в длительном процессе выдвижения новых гипотез и их экспериментальной проверке.» К. Шеннон.

В юриспруденции

Правовое определение понятия «информация» дано в федеральном законе от 27 июля 2006 года № 149-ФЗ «Об информации, информационных технологиях и о защите информации» (Статья 2): «информация — сведения (сообщения, данные) независимо от формы их представления».

Федеральный закон № 149-ФЗ определяет и закрепляет права на защиту информации и информационную безопасность граждан и организаций в ЭВМ и в информационных системах, а также вопросы информационной безопасности граждан, организаций, общества и государства.

В теории управления

В теории управления (кибернетике), предметом исследования которой являются основные законы управления, то есть развития систем управления, информацией называются сообщения, получаемые системой из внешнего мира при адаптивном управлении (приспособлении, самосохранении системы управления).

В кибернетике

Основоположник кибернетики Норберт Винер говорил об информации так:

— Н. Винер Кибернетика, или управление и связь в животном и машине; или Кибернетика и общество

Эта мысль Винера дает прямое указание на объективность информации, то есть её существование в природе независимо от сознания (восприятия) человека.

Материальная система в кибернетике рассматривается как множество объектов, которые сами по себе могут находиться в различных состояниях, но состояние каждого из них определяется состояниями других объектов системы. В природе множество состояний системы представляет собой информацию, сами состояния представляют собой первичный код, или код источника. Таким образом, каждая материальная система является источником информации.

Субъективную (семантическую) информацию кибернетика определяет как смысл или содержание сообщения. (см. там же) Информация — это характеристика объекта.

Информация в материальном мире

Информация — одно из общих понятий, связанных с материей. Информация существует в любом материальном объекте в виде многообразия его состояний и передается от объекта к объекту в процессе их взаимодействия. Существование информации как объективного свойства материи логически вытекает из известных фундаментальных свойств материи — структурности, непрерывного изменения (движения) и взаимодействия материальных объектов.

Структурность материи проявляется как внутренняя расчленённость целостности, закономерный порядок связи элементов в составе целого. Иными словами, любой материальный объект, от субатомной частицы до Метавселенной (Большой взрыв) в целом, представляет собой систему взаимосвязанных подсистем. Вследствие непрерывного движения, понимаемого в широком смысле как перемещение в пространстве и развитие во времени, материальные объекты изменяют свои состояния. Состояния объектов изменяется и при взаимодействиях с другими объектами.

Множество состояний материальной системы и всех её подсистем представляет информацию о системе.

Строго говоря, в силу инфинитности (неопределенности, бесконечности) свойства структурности, количество объективной информации в любом материальном объекте бесконечно. Эта информация называется полной. Однако можно выделять структурные уровни с конечными множествами состояний. Информация, существующая на структурном уровне с конечным числом состояний, называется частной. Для частной информации имеет смысл понятие количество информации.

В зависимости от материальной формы носителя, информация бывает двух основных видов — аналоговая и дискретная. Аналоговая информация изменяется во времени непрерывно, и принимает значения из континуума значений. Дискретная информация изменяется в некоторые моменты времени и принимает значения из некоторого множества значений.

Любой материальный объект или процесс является первичным источником информации. Все возможные его состояния составляют код источника информации. Мгновенное значение состояний представляется как символ («буква») этого кода.

Перенос информации источника на структуру носителя называется кодированием. При этом происходит преобразование кода источника в код носителя. Носитель с перенесенным на него кодом источника в виде кода носителя называется сигналом.

Приемник сигнала имеет свой набор возможных состояний, который называется кодом приемника. Сигнал, взаимодействуя с объектом-приемником, изменяет его состояния. Процесс преобразования кода сигнала в код приёмника называется декодированием.

Передачу информации от источника приемнику можно рассматривать как информационное взаимодействие. Информационное взаимодействие кардинально отличается от других взаимодействий. При всех других взаимодействиях материальных объектов происходит обмен веществом и (или) энергией. При этом один из объектов теряет вещество или энергию, а другой получает их. Это свойство взаимодействий называется симметричностью. При информационном взаимодействии приемник получает информацию, а источник не теряет её. Информационное взаимодействие несимметрично.

Объективная информация сама по себе не материальна, она является свойством материи, как, например, структурность, движение, и существует на материальных носителях в виде своих кодов.

Информация в живой природе

Живая природа сложна и разнообразна. Источниками и приемниками информации в ней являются живые организмы и их клетки. Организм обладает рядом свойств, отличающих его от неживых материальных объектов. Основные из них:

Организм, рассматриваемый как система, имеет иерархическую структуру. Эта структура относительно самого организма подразделяется на внутренние уровни: молекулярный, клеточный, уровень органов и, наконец, собственно организм. Однако организм взаимодействует и с надорганизменными живыми системами, уровнями которых являются популяция, экосистема и вся живая природа в целом (биосфера).

Между всеми этими уровнями циркулируют потоки не только вещества и энергии, но и информации.

Информационные взаимодействия в живой природе происходят так же, как и в неживой. Вместе с тем, живая природа в процессе эволюции создала широкое разнообразие источников, носителей и приёмников информации.

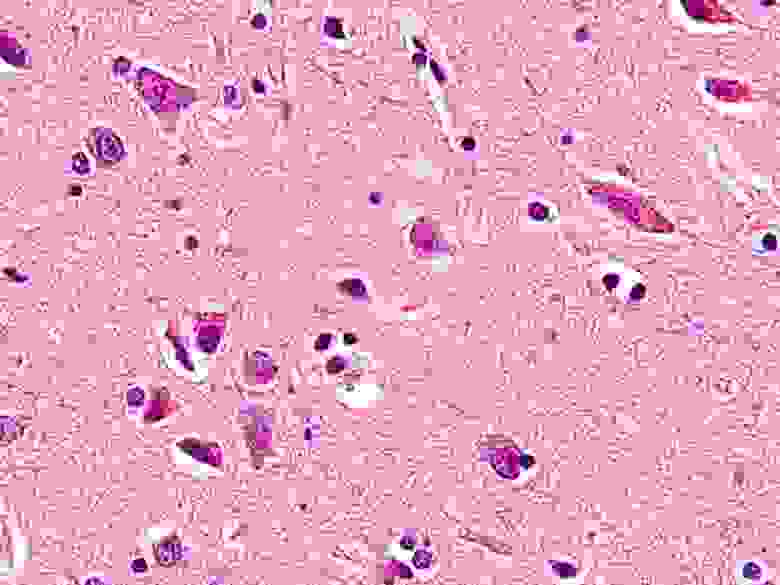

Реакция на воздействия внешнего мира проявляется у всех организмов, поскольку она обусловлена раздражимостью. У высших организмов адаптация к внешней среде носит характер сложной деятельности, которая эффективна лишь при достаточно полной и своевременной информации об окружающей среде. Приёмниками информации из внешней среды у них являются органы чувств, к которым относят зрение, слух, обоняние, вкус, осязание и вестибулярный аппарат, рецепторы чувства боли, рецепторы температуры, рецепторы тактильных ощущений. Во внутренней структуре организмов имеются многочисленные внутренние рецепторы, связанные с нервной системой. Нервная система состоит из нейронов, отростки которых аксоны и дендриты представляют собой аналог каналов передачи информации. Главными органами, обеспечивающими хранение и обработку информации у позвоночных, являются спинной мозг и головной мозг. В соответствии с особенностями строения органов чувств информацию, воспринимаемую организмом, можно классифицировать как визуальную, слуховую, вкусовую, обонятельную и тактильную, температурную, информацию вестибулярного аппарата.

Пример (продолжение). Попадая на сетчатку человеческого глаза, сигнал особым образом возбуждает составляющие её клетки. Нервный импульсы клеток через акcоны передаются в мозг. Мозг запоминает это ощущение в виде определенной комбинации состояний составляющих его нейронов. (Продолжение примера — в секции «Информация в человеческом обществе»).

Накапливая информацию, мозг создает на своей структуре связную информационную модель окружающего мира.

В живой природе для организма — приёмника информации важной характеристикой является её доступность. Количество информации, которое нервная система человека способна подать в мозг при чтении текстов, составляет примерно 1 бит за 1/16 с.

Исследование организмов затруднено их сложностью. Допустимая для неживых объектов абстракция структуры как математического множества вряд ли допустима для живого организма, потому что для создания более или менее адекватной абстрактной модели организма необходимо учесть все иерархические уровни его структуры. Поэтому сложно ввести меру количества информации. Очень сложно определяются связи между компонентами структуры. Если известно, какой орган является источником информации, то что является сигналом и что приемником?

До появления вычислительных машин биология занимающаяся исследованиями живых организмов, применяла только качественные, т.е. описательные модели. В качественной модели учесть информационные связи между компонентами структуры практически невозможно. Электронно-вычислительная техника позволила применить в биологических исследованиях новые методы, в частности, метод машинного моделирования, предполагающий математическое описание известных явлений и процессов, происходящих в организме, добавление к ним гипотез о некоторых неизвестных процессах и расчет возможных вариантов поведения организма. Полученные варианты сравниваются с реальным поведением организма, что позволяет определить истинность или ложность выдвинутых гипотез. В таких моделях можно учесть и информационное взаимодействие.

Чрезвычайно сложными являются информационные процессы, обеспечивающие существование самой жизни. И хотя интуитивно понятно, что это свойство прямо связано с формированием, хранением и передачей полной информации о структуре организма, абстрактное описание этого феномена представлялось до некоторых пор невозможным. Тем не менее, информационные процессы, обеспечивающие существование этого свойства, частично раскрыты благодаря расшифровке генетического кода и прочтению геномов различных организмов.

Информация в человеческом обществе

Развитие материи в процессе движения направлено в сторону усложнения структуры материальных объектов. Одна из самых сложных структур – человеческий мозг. Пока это единственная известная нам структура, обладающая свойством, которое сам человек называет сознанием. Говоря об информации мы, как мыслящие существа, априорно подразумеваем, что информация, кроме её наличия в виде принимаемых нами сигналов, имеет ещё и какой-то смысл. Формируя в своем сознании модель окружающего мира как взаимосвязанную совокупность моделей его объектов и процессов, человек использует именно смысловые понятия, а не информацию. Смысл — сущность любого феномена, которая не совпадает с ним самим и связывает его с более широким контекстом реальности. Смысл — понятие, описывающее глобальное содержание некоторого высказывания (см. БСЭ. Смысл). Само слово прямо указывает, что смысловое содержание информации могут формировать только мыслящие приемники информации. В человеческом обществе решающее значение приобретает не сама информация, а её смысловое содержание.

Пример (продолжение). Испытав такое ощущение, человек присваивает объекту понятие — «помидор», а его состоянию понятие — «красный цвет». Кроме того, его сознание фиксирует связь: «помидор» — «красного цвета». Это и есть смысл принятого сигнала. (Продолжение примера: ниже в этой секции).

Способность мозга создавать смысловые понятия и связи между ними является основой сознания. Сознание можно рассматривать как саморазвивающуюся смысловую модель окружающего мира.

Смысл это не информация. Информация существует только на материальном носителе. Сознание человека считается нематериальным. Смысл существует в сознании человека в виде слов, образов и ощущений. Человек может произносить слова не только вслух, но и «про себя». Он также «про себя» может создавать (или вспоминать) образы и ощущения. Однако, он может восстановить информацию, соответствующую этому смыслу, произнеся слова или написав их.

Пример (продолжение). Если слова «помидор» и «красный цвет» — смысл понятий, то где же тогда информация? Информация содержится в мозге в виде определенных состояний его нейронов. Она содержится также в напечатанном тексте, состоящем из этих слов, и при кодировании букв трехразрядным двоичным кодом её количество равно 120 бит. Если произнести слова вслух, информации будет значительно больше, но смысл останется тем же. Наибольшее количество информации несёт зрительный образ. Это отражается даже в народном фольклоре — «лучше один раз увидеть, чем сто раз услышать».

Восстановленная таким образом информация называется семантической информацией, поскольку она кодирует смысл некоторой первичной информации (семантика).

| ПОМИДОР — КРАСНЫЙ |

| Семантическая информация |

Услышав (или увидев) фразу, произнесенную (или написанную) на языке, которого человек не знает, он получает информацию, но не может определить её смысл. Поэтому для передачи смыслового содержания информации необходимы некоторые соглашения между источником и приемником о смысловом содержании сигналов, то есть слов. Такие соглашения могут быть достигнуты в процессе общения. Общение является одним из важнейших условий существования человеческого общества. Общение включает в себя следующие информационные процессы:

Хранение информации

Хранение информации осуществляется с помощью её переноса на некоторые материальные носители. Семантическая информация, зафиксированная на материальном носителе для хранения, называется документом.

Хранить информацию человечество научилось очень давно. В наиболее древних формах хранения информации использовалось расположение предметов — раковин и камней на песке, узелков на верёвке. Существенным развитием этих способов явилась письменность — графическое изображение символов на камне, глине, папирусе, бумаге. Огромное значение в развитии этого направления имело изобретение книгопечатания. За свою историю человечество накопило огромный объём информации в библиотеках, архивах, периодических изданиях и других письменных документах.

В настоящее время особое значение получило хранение информации в виде последовательностей двоичных символов. Для реализации этих методов используются разнообразные запоминающие устройства. Они являются центральным звеном систем хранения информации. Кроме них в таких системах используются средства поиска информации (поисковая система), средства получения справок (информационно-справочные системы) и средства отображения информации (устройство вывода). Сформированные по назначению информации такие информационные системы образуют базы данных, банки данных и база знаний.

Передача информации

Передачей семантической информации называется процесс её пространственного переноса от источника к получателю (адресату). Передавать и получать информацию человек научился даже раньше, чем хранить её. Речь является способом передачи, который использовали наши далекие предки в непосредственном контакте (разговоре) — ею мы пользуемся и сейчас. Для передачи информации на большие расстояния необходимо использовать значительно более сложные информационные процессы.

Для осуществления такого процесса информация должна быть некоторым образом оформлена (представлена). Для представления информации используются различные знаковые системы — наборы заранее оговоренных смысловых символов: предметов, картинок, написанных или напечатанных слов естественного языка. Представленная с их помощью семантическая информация о каком-либо объекте, явлении или процессе называется сообщением.

Очевидно, что для передачи сообщения на расстояние информация должна быть перенесена на какой-либо мобильный носитель. Носители могут перемещаться в пространстве с помощью транспортных средств, как это происходит с письмами, посылаемыми по почте. Такой способ обеспечивает полную достоверность передачи информации, поскольку адресат получает оригинал сообщения, однако требует значительного времени для передачи. С середины XIX века получили распространение способы передачи информации, использующие естественно распространяющийся носитель информации — электромагнитные колебания (электрические колебания, радиоволны, свет). Реализация этих способов требует:

Использование электромагнитных носителей делает доставку сообщения адресату почти мгновенной, однако требует дополнительных мер по обеспечению качества (достоверности и точности) передаваемой информации, поскольку реальные каналы связи подвержены воздействию естественных и искусственных помех.

Устройства, реализующие процесс передачи данных, образуют системы связи. В зависимости от способа представления информации системы связи можно подразделять на знаковые (телеграф, телефакс), звуковые (телефон), видео и комбинированные системы (телевидение). Наиболее развитой системой связи в наше время является Интернет.

Обработка информации

Поскольку информация нематериальна, её обработка заключается в различных преобразованиях. К процессам обработки можно отнести любые переносы информации с носителя на другой носитель. Информация, предназначенная для обработки, называется данными.

Основным видом обработки первичной информации, полученной различными приборами, является преобразование в форму, обеспечивающую её восприятие органами чувств человека. Так, фотоснимки космоса, полученные в рентгеновских лучах, преобразуются в обычные цветные фотографии с использованием специальных преобразователей спектра и фотоматериалов. Приборы ночного видения преобразуют изображение, получаемое в инфракрасных (тепловых) лучах, в изображение в видимом диапазоне. Для некоторых задач связи и управления необходимо преобразование аналоговой информации в дискретную и наоборот. Для этого используются аналого-цифровые и цифро-аналоговые преобразователи сигналов.

Важнейшим видом обработки семантической информации является определение смысла (содержания), заключающегося в некотором сообщении. В отличие от первичной семантическая информация не имеет статистических характеристик, то есть количественной меры — смысл либо есть, либо его нет. А сколько его, если он есть — установить невозможно. Содержащийся в сообщении смысл описывается на искусственном языке, отражающем смысловые связи между словами исходного текста. Словарь такого языка, называемый тезаурусом, находится в приемнике сообщения. Смысл слов и словосочетаний сообщения определяется путем их отнесения к определенным группам слов или словосочетаний, смысл которых уже установлен. Тезаурус, таким образом, позволяет установить смысл сообщения и, одновременно, пополняется новыми смысловыми понятиями. Описанный вид обработки информации применяется в информационно-поисковых системах и системах машинного перевода.

Одним из широко распространенных видов обработки информации является решение вычислительных задач и задач автоматического управления с помощью вычислительных машин.

Обработка информации всегда производится с некоторой целью. Для её достижения должен быть известен порядок действий над информацией, приводящий к заданной цели. Такой порядок действий называется алгоритмом. Кроме самого алгоритма необходимо также некоторое устройство, реализующее этот алгоритм. В научных теориях такое устройство называется автоматом.

Следует отметить как важнейшую особенность информации тот факт, что в силу несимметричности информационного взаимодействия при обработке информации возникает новая информация, а исходная информация не теряется.

Информация в науке

В современном мире информация представляет собой один из важнейших ресурсов и, в то же время, одну из движущих сил развития человеческого общества. Информационные процессы, происходящие в материальном мире, живой природе и человеческом обществе изучаются (или, по крайней мере, учитываются) всеми научными дисциплинами от философии до маркетинга.

Возрастающая сложность задач научных исследований привела к необходимости привлечения к их решению больших коллективов ученых разных специальностей. Поэтому практически все рассматриваемые ниже теории являются междисциплинарными.

Исторически сложилось так, что исследованием непосредственно информации занимаются две комплексных отрасли науки — кибернетика и информатика.

Современная кибернетика — это мультидисциплинарная отрасль науки, исследующая сверхсложные системы, такие как:

Информатика, сформировавшаяся как наука в середине прошлого века, отделилась от кибернетики и занимается исследованиями в области способов получения, хранения, передачи и обработки семантической информации.

Обе эти отрасли используют несколько основополагающих научных теорий. К ним относятся теория информации и её разделы — теория кодирования, теория алгоритмов и теория автоматов.

Исследования смыслового содержания информации основываются на комплексе научных теорий под общим названием семиотика.

Теория информации

Теория информации — комплексная, в основном математическая теория, включающая в себя описание и оценки методов извлечения, передачи, хранения и классификации информации.

Рассматривает носители информации как элементы абстрактного (математического) множества, а взаимодействия между носителями как способ расположения элементов в этом множестве. Такой подход дает возможность формально описать код информации, то есть определить абстрактный код и исследовать его математическими методами. Для этих исследований применяет методы теории вероятностей, математической статистики, линейной алгебры, теории игр и других математических теорий.

Основы этой теории заложил американский учёный Э. Хартли в 1928 г., который определил меру количества информации для некоторых задач связи. Позднее теория была существенно развита американским учёным К. Шенноном, российскими учёными А. Н. Колмогоровым, В.М Глушковым и др.

Современная теория информации включает в себя как разделы теорию кодирования, теорию алгоритмов, теорию цифровых автоматов (см. ниже) и некоторые другие.

Существуют и альтернативные теории информации, например «Качественная теория информации», предложенная польским учёным М. Мазуром.

Теория алгоритмов

C понятием алгоритма знаком любой человек, даже не подозревая об этом. Вот пример неформального алгоритма:

«Помидоры нарезать кружочками или дольками. Положить в них нашинкованный лук, полить растительным маслом, затем посыпать мелко нарезанным стручковым перцем, перемешать. Перед употреблением посыпать солью, уложить в салатник и украсить зеленью петрушки.» (Салат из помидоров).

Первые в истории человечества правила решения арифметических задач были разработаны одним из известных учёных древности Аль-Хорезми в IX веке нашей эры. В его честь формализованные правила для достижения какой-либо цели называют алгоритмами (ранее употреблялся термин «алгорифм»).

Предметом теории алгоритмов является нахождение методов построения и оценки эффективных (в том числе и универсальных) вычислительных и управляющих алгоритмов для обработки информации. Для обоснования таких методов теория алгоритмов использует математический аппарат теории информации.

Современное научное понятие алгоритмов как способов обработки информации введено в работах Э. Поста и А. Тьюринга в 20-х годах ХХ века (Машина Тьюринга). Большой вклад в развитие теории алгоритмов внесли русские ученые А. Марков (Нормальный алгоритм Маркова) и А. Колмогоров.

Теория автоматов

Теория автоматов — раздел теоретической кибернетики, в котором исследуются математические модели реально существующих или принципиально возможных устройств перерабатывающих дискретную информацию в дискретные моменты времени.

Понятие автомата возникло в теории алгоритмов. Если существуют некоторые универсальные алгоритмы решения вычислительных задач, то должны существовать и устройства (пусть и абстрактные) для реализации таких алгоритмов. Собственно, абстрактная машина Тюринга, рассматриваемая в теории алгоритмов, является в то же время и неформально определённым автоматом. Теоретическое обоснование построения таких устройств является предметом теории автоматов.

Теория автоматов использует аппарат математических теорий — алгебры, математической логики, комбинаторного анализа, теории графов, теории вероятностей и др.

Теория автоматов вместе с теорией алгоритмов являются основной теоретической базой для создания электронных вычислительных машин и автоматизированных управляющих систем.

Семиотика

Семиотика — комплекс научных теорий, изучающих свойства знаковых систем. Наиболее существенные результаты достигнуты в разделе семиотики — семантике. Предметом исследований семантики является смысловое содержание информации.

Знаковой системой считается система конкретных или абстрактных объектов (знаков, слов), с каждым из которых определенным образом сопоставлено некоторое значение. В теории доказано, что таких сопоставлений может быть два. Первый вид соответствия определяет непосредственно материальный объект, который обозначает это слово и называется денотат (или, в некоторых работах, — номинат). Второй вид соответствия определяет смысл знака (слова) и называется концепт. При этом исследуются такие свойства сопоставлений как «смысл», «истинность», «определимость», «следование», «интерпретация» и др. Для исследований используется аппарат математической логики и математической лингвистики.

Идеи семантики, намеченные ещё Г. В. Лейбницем и Ф де Соссюром в XIX веке, сформулировали и развили Ч. Пирс (1839—1914), Ч. Моррис (р. 1901), Р. Карнап (1891—1970) и др.

Основным достижением теории является создание аппарата семантического анализа, позволяющего представить смысл текста на естественном языке в виде записи на некотором формализованном семантическом (смысловом) языке.

Семантический анализ является основой для создания устройств (программ) машинного перевода с одного естественного языка на другой.

Дезинформация

Дезинформацией (также дезинформированием) называется один из способов манипулирования информацией, как то введение кого-либо в заблуждение путём предоставления неполной информации или полной, но уже не нужной информации, или полной, но не в нужной области, искажения контекста, искажения части информации.

Цель такого воздействия всегда одна — оппонент должен поступить так, как это необходимо манипулятору. Поступок объекта, против которого направлена дезинформация, может заключаться в принятии нужного манипулятору решения или в отказе от принятия невыгодного для манипулятора решения. Но в любом случае конечная цель — это действие, которое будет предпринято.